This study conducts an interpretive analysis of the regulatory cluster on identification obligations, including the "Measures", to address the urgent compliance needs arising from the current implementation of the "Measures". Moreover, it fills the gap in the current research regarding the lack of law and economics analysis, clarifies the functional limitations of the identification system in terms of efficiency, and expounds that the interpretation of identification obligations should follow the principle of "cost reduction and efficiency improvement". What's more, it reflects on some theoretical viewpoints that currently support the legitimacy of identification obligations and examines the interpretive limits of "the theory of product information disclosure obligation". Lastly, it conducts a detailed analysis of two interpretive approaches to the "Exception to Explicit Identification" in Article 9 of the "Measures", providing solutions for the implementation and optimization of the "Measures".

At present, there is an overly optimistic perception of the functional effectiveness of the identification system, leading to a tendency to expand the scope of supervision. However, the progress of substantive transparency in China's identification system remains limited. The identification of generated content is prone to problems such as devaluation of information value and weakening of the contributions of human co-creators, and undermines users' and platforms' willingness to comply with identification requirements. Meanwhile, the identification of generated content has functional limitations: it cannot replace judgments on information quality, authenticity, or copyright, and is easily tampered with, which affects the function of traceability supervision. From the cost-benefit perspective, if the social welfare brought by identification is limited by "formal transparency" and "watermark tampering", and is lower than social costs such as technology construction, value devaluation, and dispute resolution, the legitimacy of the system will be difficult to justify. In an environment of "prevalent non-compliance", high rigid penalties are not only ineffective but also incur high law enforcement costs.

To promote the long-term development of the identification system, it is necessary to establish a legal and economic analysis mindset, adhere to the principle of maximizing functional effectiveness, promote the transition to substantive transparency, and conduct substantive labeling of the extent and methods of AI participation. It is essential to reflect on the limitations of the product information disclosure theory and emphasize the collaborative fulfillment of identification obligations by multiple subjects. The principle of differentiated interpretation for cost control should be upheld: requirements should be adjusted according to differences in subjects and risk scenarios, and explicit identification can be reduced or canceled in low-risk scenarios. The identification obligations of platforms shall be supervised by administrative authorities, relying on the four-dimensional framework of "legal provisions - departmental regulations - national standards - platform rules"; the obligations of users shall be mainly supervised by platforms, which need to provide convenient tools and prompts, and establish a proportional sanction and appeal mechanism. The interpretation of Article 9 of the "Measures" needs to shift from the "supervision-oriented perspective" to the "development-oriented perspective". As a common exception to relevant provisions, explicit identification should only be mandatory in high-risk scenarios, while in other scenarios, it may not be mandatory and can be determined in accordance with user agreements.

Further efforts should be made to improve empirical research and quantitative analysis on the implementation effects of the AIGC identification system, refine the standards for AIGC risk classification, and improve the specific provisions of penalties such as administrative penalties for identification obligations applicable to platforms and users. In addition, the relationships between AIGC identification, copyright, and fair use of data need to be further clarified.

随着生成式人工智能深度融入人类生活,人工智能生成合成内容席卷网络,“人机共创”成为常态。人类越来越难以将人工智能生成合成内容与人类创作内容区分开[1],信息生态系统信任框架面临全新挑战,虚假信息、深度伪造欺诈等风险冲击着社会信任秩序。国家互联网信息办公室、工业和信息化部等四部门联合发布的《人工智能生成合成内容标识办法》(简称《标识办法》)自2025年9月1日起施行,在人工智能生成合成服务提供者(以下简称“服务提供者”)标识义务之外,进一步明确了生成合成内容用户、提供网络信息内容传播服务的服务提供者(以下简称“信息管理平台”)以及应用程序分发平台的标识义务,区分“显式标识”与“隐式标识”两种生成合成内容标识形式,并借助《标识办法》第9条的“显式标识例外”,以更好地平衡生成内容使用需求与信息生态系统监管需要。

既有研究对人工智能生成内容标识义务(简称“标识义务”)的探讨主要以人工智能透明度原则为理论支撑[2-3],也有部分学者主张依据产品信息披露义务的扩张和著作权保护需求,证成标识义务的正当性(张继红,2024)。当下亟需加强对《标识办法》及相关标识义务规范体系的解释论研究,尤其是填补《标识办法》主体标识义务规范罅隙与第9条“显式标识例外”的解释疑难问题,对人工智能生成内容标识制度(下文简称“标识制度”)功能实效仍需冷静审视,相关研究尚未充分引入“成本收益分析”思维。

本文边际贡献主要体现在以下几个方面:第一,从解释学角度对《标识办法》等标识义务规范群进行研究,因应当前《标识办法》施行的紧迫需求;第二,弥补当前研究在法经济分析思维方面的不足,明确标识制度在效益维度上的功能局限,阐明标识制度实施过程中的各类成本,指出对标识义务的解释应遵循“降本增效”原则;第三,对当前支撑标识义务正当性的部分理论观点进行思辨,检视“产品信息披露义务说”的解释限度,以及标识制度对于著作权保护的效用限度;第四,对《标识办法》第9条“显式标识例外”两种解释路径进行详细分析,为《标识办法》实施及优化提供参考。

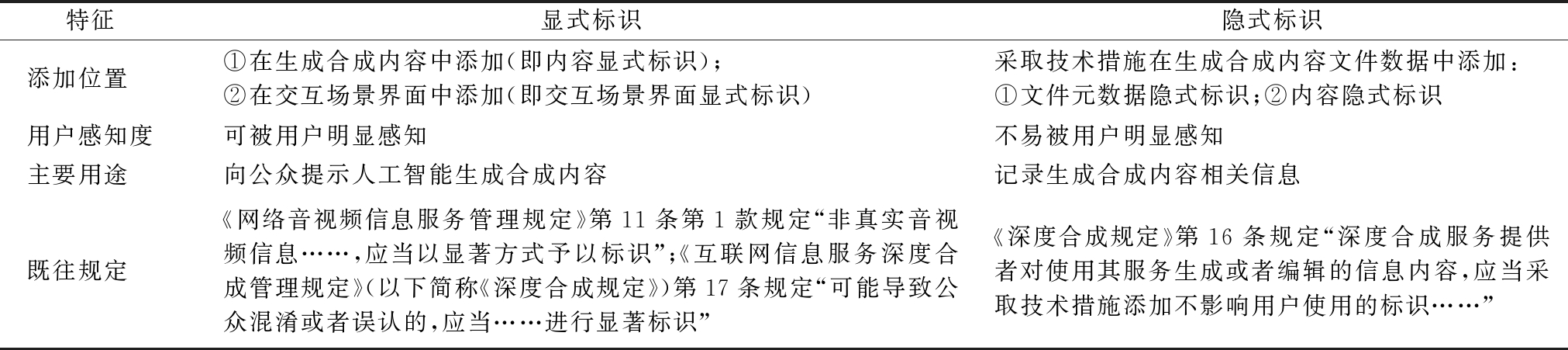

对标识制度功能实效的理解,影响标识义务范围的阐释。当前,生成合成内容标识制度功能实效可能存在被高估。显式标识能够促进人工智能生成信息披露,提升受众警惕度,减少错误决策成本;隐式标识则能保障溯源监管,记录相关信息。显式标识与隐式标识对比如表1所示。用户及平台标识意愿不足会影响信息披露,标识制度本身存在一定局限,其不等同于信息真伪、质量和著作权判断,且极易被篡改,从而影响溯源监管。因此,澄清其功能限度,可为后续解释标识义务范围及履行方式奠定基础。

表1 显式标识与隐式标识对比

Table 1 Comparison between explicit identification and implicit identification

特征 显式标识隐式标识添加位置①在生成合成内容中添加(即内容显式标识);②在交互场景界面中添加(即交互场景界面显式标识)采取技术措施在生成合成内容文件数据中添加:①文件元数据隐式标识;②内容隐式标识用户感知度可被用户明显感知不易被用户明显感知主要用途向公众提示人工智能生成合成内容记录生成合成内容相关信息既往规定《网络音视频信息服务管理规定》第11条第1款规定“非真实音视频信息……,应当以显著方式予以标识”;《互联网信息服务深度合成管理规定》(以下简称《深度合成规定》)第17条规定“可能导致公众混淆或者误认的,应当……进行显著标识”《深度合成规定》第16条规定“深度合成服务提供者对使用其服务生成或者编辑的信息内容,应当采取技术措施添加不影响用户使用的标识……”

标识制度的实践困境在于,用户主动标识意愿有限。如“网红种草”平台虽要求“网红”标识受赞助的“种草”内容,但关注者很可能降低对于标识“赞助”内容的依赖程度[4]。与之类似,生成合成内容“贴标”也可能伴随着内容价值矮化、作者贡献不足等负面印象。对于服务提供者和信息管理平台而言,主动补充标识意味着用户后续使用不便,以及使用量、内容流量可能会遭遇负面影响。同时,信息管理平台虽应对平台内容进行人工智能生成检测并补充标识,但错误识别可能会给平台带来大量申诉处理和纠纷解决成本,这也会影响平台对生成合成内容进行检测标识的意愿。此外,从合规措施角度出发,平台企业当前提供给用户的标识功能通常仅有笼统说明“是否包含AI生成内容”选项,而不包含对于人类贡献内容的信息披露提示。在“人机共创”普遍化背景下,“形式透明”无法充分披露机器与人类各自的贡献度与分工内容(马子斌,2024),人工智能工作模式及潜在风险依然处于“黑箱”之中,难以完全实现信息披露的制度功能,也影响用户及平台主动标识意愿。尤其是在发布文字内容时,若涉及人工智能对框架搭建、文字润色、扩写人类作者观点等贡献,“形式透明”标识模式极易弱化作者贡献,带来知识产权风险,影响用户标识意愿。

生成合成内容标识不等同于信息真伪和质量判断,也无法等同于著作权判断。尽管生成合成内容对创作秩序和传播秩序存在挑战[5],用户可能通过署名简单获取生成合成内容著作权的权属推定[6],但署名不真实和虚假信息并不是在生成式人工智能时代才产生的问题,无法通过生成合成内容标识制度予以完全解决。人工智能生成合成内容标识并不直接与信息真伪、信息质量、信息来源挂钩。附着生成合成内容标识的图像,其知识产权未必全部属于公共领域[7]。如“奥特曼案”广州互联网法院裁判观点认为,显式标识义务的履行有利于知识产权人“明确认识到生成物系由人工智能生成,进而采取更具针对性和有效的维权措施,更好地保护其权利”,因此标识义务不仅是对公众知情权的尊重,也是对权利人的一种保护性义务((2024)粤0192民初113号)。该观点虽具有合理性,但亦存在对显式标识效益的积极化。纵使在不涉及人工智能生成合成场景下,他人对权利人享有著作权的奥特曼形象进行改编创作,同样属于侵犯其复制权、改编权的行为。纵使未有显式标识,被告人在自身诉讼答辩意见中亦有充分意愿主动披露该内容属于生成合成,从而引导原告申请追加被告或者另案起诉生成合成服务提供者。因此,生成合成内容标识的信息披露功能所带来的社会效益虽然是存在的,但亦是有限的。

显式标识能够缓解受众信息不对称,隐式标识则发挥着便利溯源监管的功能。深度合成服务提供者对使用其服务生成或者编辑的信息内容,需采用技术措施添加不影响用户使用的标识,并依法保存日志信息。但实践困境在于,当前数字水印容易被篡改。苏黎世联邦理工学院的一项研究表明,缺乏统一性的人工智能生成文本水印容易被删除、窃取和复制,从而使社会公众误信其不应该信任的文本[8]。深度伪造工具、对抗样本攻击等恶意技术手段,可能会伪造或篡改标识系统的元数据,进而影响标识的溯源监管功能[9]。此外,对于文本类生成合成内容,可能难以添加可靠的数字水印。人工智能生成合成内容检测水平有待提升,信息管理平台在补充标识过程中很可能会发生误判,如对于非生成合成补充内容进行错误标识,从而影响标识制度溯源监管功能的发挥。在监管层面,《标识办法》第10条第2款明确禁止“恶意删除、篡改、伪造、隐匿生成合成内容标识,不得为他人实施上述恶意行为提供工具或者服务,不得通过不正当标识手段损害他人合法权益”,但相关罚则如何解释有待明确,相关解释路径直接影响标识制度施行效果。

标识制度功能限度论揭示当前标识制度设置的预期制度功能尚未完全发挥,而其实施后可能带来的制度成本也未得到系统检视。对现行法律规范体系下标识义务的解释,应当运用法经济分析思维,紧密围绕其功能实效最大化原则(信息披露、溯源监管),通过标识制度的实质透明化解释、反思产品信息披露义务及安全保障义务理论对标识义务解释上的局限性,明确标识义务的落实应强调多元主体协同化。同时,遵循主体差异与风险场景差异区分原则,解释《标识办法》等规范的模糊地带,降低制度实施成本。

2.1.1 标识制度的实质透明化解释

标识制度保障信息披露功能,与生成合成内容透明度原则紧密关联。生成合成内容透明度原则包括形式透明和实质透明:前者强调对人工智能基础信息的披露,使他者得以知晓人工智能部署;后者则更偏重对人工智能的可解释性,强调以可被理解的方式解释,从而打破知识和认知壁垒。实质透明度原则在人工智能领域的运用有助于促进用户、社会对人工智能运作原理和功能效用的理性感知或认知,从而建立信息生态系统中对生成合成内容的认知、信任与认同模式(张永忠,2024)。处于信息优势地位者需对信息进行披露,进而使传播受众依靠外在标识对信息进行辨别。然而,当前《标识办法》等标识制度规范并未对面向受众信息的实质透明作出规定,实践中多数标识仅对是否涉及生成合成内容进行简单披露。

在《标识办法》等标识义务规范实施过程中,应明确标识义务的履行区间,即最低要求为形式透明,但道德化的解释路径则是实现实质透明。标识义务的“实质透明”可从两个维度加以解释:其一,简明披露生成合成算法机制及其风险。进一步披露人工智能技术信息,以用户易于理解的方式,标识生成合成算法的训练特征和典型错误情形[10]。如在法律人工智能生成内容场景中,说明案例信息并非直接来源于最高法院裁判文书网,可能存在虚构案例风险。服务提供者应设定“服务功能的显著提示说明义务”,使用户知晓人工智能生成合成服务功能的局限性,在用户终端或官方网站说明该类服务的基本特征[11]。其二,针对人机共创场景精细化标识内容,明晰各主体贡献。例如,在用户端,提供精细化选项或自定义空间,区分人工智能贡献度及贡献模式,如“辅助创作”“辅助润色”“辅助扩写”等。通过精细化标识,缓解标识制度对人机共创场景中作者贡献的贬损,为用户端主动标识减少主观排斥心理;通过对创作主体及创作过程的信息披露,减少人工智能生成合成内容对版权法秩序的冲击。

2.1.2 产品信息披露理论说之限度

为使标识制度功能得到有效发挥,标识义务承担主体不应仅局限于平台服务提供者。当前,《标识办法》已经明确标识义务主体包括各类平台服务提供者及用户等4类主体,但《标识办法》仅涉及行为模式规范,未明确规定不履行《标识办法》规定义务的法律后果。故对相应法律责任的解释,需找寻上位法规定及相应理论渊源。有学者认为,标识义务可借助产品信息披露义务的扩张予以解释[6],主张生成合成服务提供者和信息管理平台为标识义务的核心主体。针对我国《标识办法》所提及的用户和应用商店这两类主体,考虑到应用商店对传播秩序的影响作用较小,以及用户标识义务可由平台实现,故认为在标识义务构建初期,可暂时将其排除在标识主体之外(宋歌,2025),这种观点有待进一步澄清其阐释限度。

一方面,对人工智能生成合成服务提供者而言,将生成合成内容解读为“智能产品”,并以输入提示词的对应用户作为“消费者”似乎是一种顺畅的解读。《中华人民共和国产品质量法》《中华人民共和国消费者权益保护法》均为经营者设置了标识真实产品信息的义务。产品信息披露义务的理论核心在于赋予消费者知情权[12],避免消费者基于不对称信息而作出错误消费决策。然而,有相当一部分用户既已知晓内容由人工智能参与生成,对于这部分用户而言,对人工智能产品添加显式标识及隐式标识,显然旨在保障相关内容在后续传播环节对后续不特定信息受众保持“人工智能透明度”,这已经超出产品信息披露义务所指向的消费场景。

另一方面,对于信息管理平台、应用商店及用户而言更是如此。对于信息管理平台而言,纵使将平台内用户解释为“消费者”,也无法解释标识制度对生成合成内容由初始传播平台向外溢出的风险管理。平台外信息受众显然无法解释为平台作为“经营者/生产者”所对应的“消费者”,且信息管理平台内用户在很多情形下只是浏览生成合成内容,而非专门考虑消费生成合成内容。对于应用商店而言,则更难以借助产品信息披露义务解释《标识办法》对其规定的相关义务。应用商店负担的是核验平台标识能力的审查义务,而非标识义务,保障的是潜在、遥远、不特定生成合成信息接收者的知情权。用户标识义务更难在产品信息披露义务下得到适当解释,事实上无论其是否作为“经营者”,都被认为需要承担既有标识制度规范体系下的标识义务。用户作为平台内信息的上传主体,相比于信息管理服务平台补充的标识义务,用户对于自身上传信息是否涉及生成合成内容,可基于自身亲历性而进行更加直接、准确的标识。在规范层面,《标识办法》第1条唯一明确援引的“法律”渊源属于《中华人民共和国网络安全法》,而不涉及《中华人民共和国消费者权益保护法》《中华人民共和国产品质量法》《中华人民共和国电子商务法》等,未体现援用“消费者—经营者”框架思路。因此,产品信息披露义务理论无法完全匹配对多元主体协同标识、协力降低生成合成内容带来的外部风险解释需求。

2.1.3 标识义务多元主体协同化

为使标识制度信息披露功能有效发挥,应反思畸重平台而弱化用户标识义务的监管路径。然而,借助安全保障义务理论,也无法支撑标识义务论证。《中华人民共和国民法典》第1 198条规定的安全保障义务,主要针对的是“经营场所、公共场所的经营者、管理者或者群众性活动的组织者”,具有明确的责任场域范围限定。安全保障义务虽可解释信息管理平台的标识义务,但对于生成合成服务提供者、应用分发商店以及用户而言,显然无法将标识义务仅仅解释为对其特定责任空间的安全保障义务,其更多体现为一种风险制造者对于后续信息风险扩散的控制义务。因此,不应将标识义务狭义理解为产品信息披露义务或安全保障义务在人工智能时代的某种延伸。从立法位阶角度看,标识义务属于在法律层面尚未规范,而是基于紧迫的现实需求,由部门规章先行确立的权宜性规定。

用户相比于信息管理平台而言,能够直接接触人工智能生成合成过程,更了解信息内容的真伪和侵权风险,因此是标识义务承担的核心主体。标识义务的理论正当性和解释来源,无法基于产品信息披露义务或安全保障义务得到稳妥实现,需借助人工智能时代透明度理论予以解释。透明度理论强调在更广泛的传播场域内弥合信息不对称,其对信息不对称的缓解,不仅是针对消费者的某次消费决策,而且在信息生成、传播等不同节点,针对不同主体设定了差异化的义务要求。标识义务针对的“生成合成技术滥用、虚假信息传播扩散加剧”等问题[13],其风险具有外溢性和扩散性特征,在规制重点上应针对信息生成、传播流程中各节点角色协同关注,重视对风险的协同规制,而非借助《中华人民共和国消费者权益保护法》《中华人民共和国产品质量法》等规制框架进行片面嵌套、不当弱化对用户及应用分发商店的义务要求。因此,应构建用户自律、科技企业自治与政府监管衔接互动机制,探索共建共治共享新格局[14]。

标识制度具有促进信息披露、便利溯源监管功能,但其功能的实现需要相应制度成本支撑。标识义务无法从传统产品信息披露理论、安全保障义务理论中得到妥适解释。标识制度的实施应当更加审慎,全面检视制度实施过程中的主要成本,避免改革消耗与效益不相称的标识成本。成本收益分析法的核心思路是权衡待审查的法律规则或政策举措可能导致的各类有利或不利结果(即成本或收益),并在此基础上判断对强制标识义务范围的解释进路,何者更有助于促进社会福利最优[15-16]。标识制度成本主要包括:①标识技术成本,主要涉及服务提供者、信息管理平台。②标识监管成本,主要涉及相关行政管理部门监督标识制度实施成本、信息管理平台对平台内用户合规标识的监管成本、应用商店对平台的监管成本。③标识后果成本,主要涉及用户添加标识花费的时间成本,以及标识后可能存在的降低流量、减少内容可信度和商业价值等成本。④标识违法成本,即违反标识义务需要承担的罚款、禁言、销号等成本。⑤标识纠纷解决成本,即因不服监管过程或结果而产生的诉讼、上访、调解等成本。标识义务并非越全面严格越能产出社会效益,标识义务法律后果的具体解释,应遵循控制标识成本的区分化解释原则。

2.2.1 基于标识主体差异的区分原则证成

基于控制标识成本的区分化解释原则,违反标识义务的法律后果应遵循行政机关监管与平台自治的“多元共治”框架,以较低成本实现渐进式标识制度合规化发展。这种规制模式凸显了监管重心的分层特征——对平台侧重行政法律责任,对用户则主要依赖平台自治。

对于生成合成服务提供者和内容传播服务提供者而言,《中华人民共和国网络安全法》第22条第1款明确要求网络产品与服务必须符合强制性国家标准,而国家标准《网络安全技术 人工智能生成合成内容标识办法》(下文简称《标识标准》)则在引言部分明确限定了规范主体,将用户和互联网应用程序分发平台排除在外。《标识办法》与《标识标准》在规范主体上有明显区别,这体现出立法者对于不同主体违反标识义务法律后果的区分化规制路径。根据《中华人民共和国网络安全法》第60条规定,服务提供者和信息管理平台若违反《标识办法》,且未及时修复信息安全漏洞、履行用户告知与主管部门报告义务,将可能面临“双轨制”处罚:首先由主管部门责令改正并警告;拒不整改或引发网络安全危害的,将被处以5万~50万元罚款,直接责任人亦需承担1万~10万元罚款。该法律后果不适用于用户及互联网应用程序分发平台。此外,针对生成合成服务提供者,《互联网信息服务深度合成管理规定》第21条第2款赋予国家网信办及相关主管部门更细致的监管权限。当发现存在重大信息安全风险时,主管部门可依法要求服务提供者和技术支持者采取暂停信息更新、限制用户注册等措施,相关主体需按要求完成整改并消除隐患。在行政监管体系外,生成合成服务提供者需同时接受应用程序分发平台的上架审核、安全评估,若违反标识义务可能遭受不予上架、警示、暂停服务或者下架等处置措施。

对于用户和互联网应用程序分发平台违反标识义务的法律后果,则暂无“法律”规定直接对应。对于用户违反标识义务的规制路径,更多依赖于《标识标准》等标识规范体系平台自治和平台引导,由平台基于用户协议对用户违反标识义务行为进行规制。这种监管模式实则是将政府监管需求下放给平台企业协助实现,称之为“协助型网络平台治理”。该模式与政府作为管理主体、平台企业作为管理对象的“管理型”模式不同[17]。政府与平台企业关系平等,且平台企业对用户违反标识义务的规制措施具有一定裁量空间。例如,《网络音视频信息服务管理规定》第14条明确规定“服务提供者可在协议中约定双方权利义务,对违规用户采取警示整改、功能限制、账号关闭等措施,并向监管部门报告处置记录”。而对互联网应用程序分发平台违反审核义务的监督,则依赖于行政监管和后续法律规定的跟进,当前尚未有规范、明确的法律后果。然而,对于存在重大安全风险生成合成内容不予显式标识的用户行为,未来可考虑在条件成熟时引入行政处罚。

2.2.2 基于风险场景差异的区分原则证成

标识义务不应针对任何场景、任何内容不加区分作出一致性要求。基于控制标识制度成本的考量,以及鉴于《中华人民共和国网络安全法》是《标识办法》唯一明确援引的上位法律,未来标识义务的解释宜紧密围绕“网络安全”的制度目标。原因在于:首先,若对显式标识义务厘定过宽,大面积用户违法将导致相关监管成本、违法成本及纠纷解决成本畸高。其次,从保障标识制度功能实效角度考虑,过度信息披露可能会造成信息接收负担,使重要信息隐藏在信息碎片中,继而花费较高制度实施成本,反而产生“吃力不讨好”的效果。最后,从信息不对称带来的危害后果考虑,对生成合成内容著作权归属的错误理解,或者对部分“AI幻觉”带来错误信息的错误理解,相比于涉及政治、证券和严重侵害私主体基本权利等重大误解而言程度较轻。而且,低质量信息与著作权模糊并非人工智能生成合成技术带来的独有问题,也非通过普遍性标识义务所能解决。

此外,标识义务在相当一段时间内难以发展为对生成合成情况和信息真伪、质量的“双轨制”标识义务。有学者认为,标识义务应集中于对高风险性和威胁性的虚假、劣质内容进行重点标记[18]。问题在于,对信息内容真伪、质量进行判断,在认识论层面比较困难。纵使在司法审判场景下,有对当事人辩论权和证据提出权的充分保障,尚可能存在对事实真伪的极大争议,更不用说仅在信息管理平台治理语境中,由信息管理平台“独断式”判断信息质量及其真伪。信息管理平台缺乏能力和精力去实质调查和判断内容真伪、质量,且此种实质判断权的正当性存在疑问,有可能因此引发大量纠纷。

在规范层面,尽管当前《标识办法》尚未对显式标识场景进行明确分类,但新增的第9条“显式标识例外”已成为现阶段基于风险场景差异作出区分化解释的核心锚点。在整体解释路径层面,应缓解过度标识带来的信息披露功能弱化,以及降低全面显式标识带来的标识后果成本(如降低流量、减少内容可信度和商业价值)、普遍显式标识义务违反下的监管成本和纠纷解决成本、义务违反者承担的违法成本。对于显式标识义务的解释应遵循风险场景区分路径:①对于具有较高公共风险或人格权侵害风险的人工智能生成内容,应坚持强制显式标识义务[19]。②对于公共安全风险较低及人格权侵害风险较低场景,运用《标识办法》第9条“显式标识例外”约定不对用户显式标识义务作出要求。结合用户合理使用需求,从安全风险、技术难度、用户体验等维度精细化设置显式标识例外场景[20],且对信息管理平台协助标识义务作出相应调整。③基于前两项内容,对《标识办法》第10条作出限缩解释。该路径的正当性在于:标识义务的核心价值并非形式合规,而在于防范深度伪造等内容造成的重大误解风险,以较低制度成本有效发挥标识制度核心功能。

根据控制标识成本的区分化原则,平台服务提供者的标识义务主要由行政机关监管,可能衔接《中华人民共和国网络安全法》第22条、第60条之最高罚款额50万元。关于信息管理平台履行标识义务范围,即《标识办法》第9条“显式标识例外”的解释,本文基于功能限度论的“成本—收益”视角,明确企业合规的实然要求与应然路径。服务提供者与信息管理平台作为新型信息生产传播主体,渐成主要垄断主体[21],负有安全监管义务(张凌寒,2023)。将平台作为当前阶段行政监管的核心对象,是维护网络信息信任秩序较为经济、高效的可行路径。

3.1.1 人工智能生成合成服务提供者的标识义务规定

根据《标识办法》第4条、5条以及《深度合成规定》第16条、第17条第1款规定,可对服务提供者所承担的标识义务进行如下类型化解析:其一,普遍性“隐式标识”义务用于记录生成合成内容相关信息。深度合成服务提供者对使用其服务生成或者编辑的信息内容,需采取技术措施添加不影响用户使用的标识,并依法保存日志信息。国家网信办在答记者问时指出,“考虑人工智能技术发展需要,针对在文本内容中添加隐式标识,在多媒体文件中添加数字水印,仍是技术难点,或可能增加企业成本,不作强制要求”,“为降低平台企业标识成本,提升落地实施的可操作、可执行性,创新提出文本符号标识、音频节奏标识、文件元数据标识等低成本实施的可行方法”[13]。文件元数据层标识嵌入,即按照特定编码格式在文件头部植入描述性信息,具体涵盖生成合成内容的属性信息、服务提供者名称或编码、内容编号等制作要素。作为元数据标识的补充形式,《标识办法》鼓励服务提供者采用数字水印等技术手段进行隐式标识,以构建多维度技术溯源体系。例如,微软将不可见水印嵌入到DALL·E3模型,并在Azure OpenAI服务中生成图像,获得内容创建时间、出处信息等[22]。其二,特定场景显式标识义务。当生成合成内容存在导致公众混淆或误认的风险时,服务提供者需履行可视化提示义务。尤其是在提供内容下载、复制、导出功能时,需确保输出文件包含符合规范的显式标识,从而形成“出厂即打标”的全链条标识追溯机制,以保障在后续传播环节的信息接收者能够清晰识别生成内容的人工智能属性。

可见,隐式标识通过元数据记录和数字水印技术构建机器可读的内容溯源框架,为监管追溯和技术鉴定提供底层数据支持;显式标识则以人类可识别的方式直接回应公众认知需求,通过可视化提示降低信息误认风险。二者在技术实现路径和功能定位上形成互补,既满足了人工智能产业发展需求,又构建了从内容生成端到传播端的全流程责任追溯机制,从而为人工智能生成内容的规范化治理提供制度保障。

3.1.2 网络信息服务平台与应用商店标识义务规定

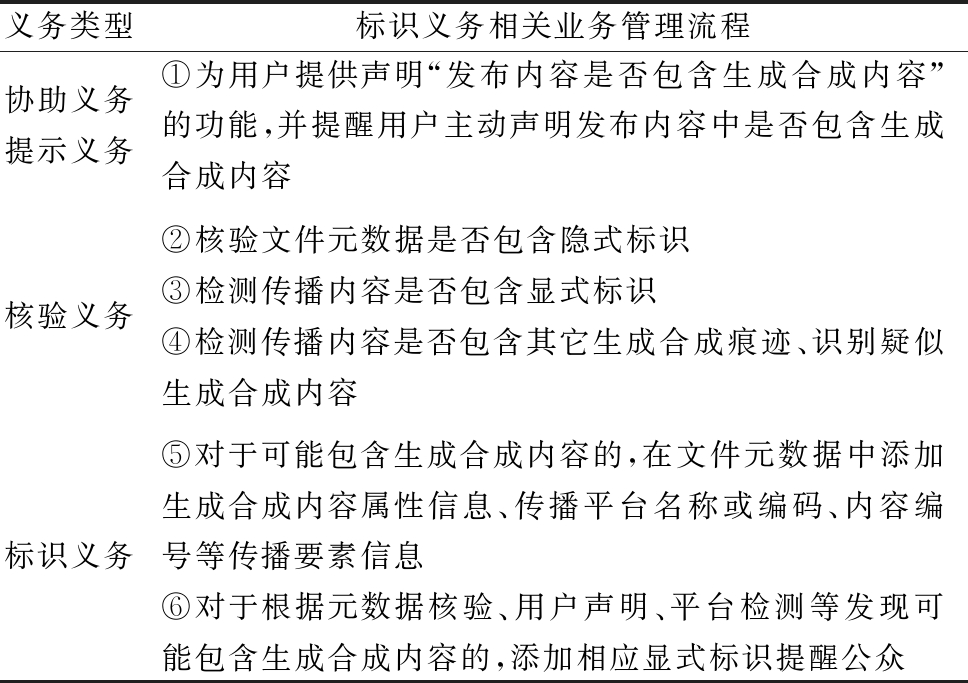

(1)信息管理平台标识义务分类与业务管理流程。提供网络信息内容传播服务的服务提供者在生成合成内容传播过程中发挥着补足标识、参与制裁、规范信息生成的重要作用,能够有效引导传播受众。要求信息管理平台承担相关标识义务,是因为其对信息具备控制力,一方面其存储了未经标识而可能误导公共信息流的生成合成信息,另一方面其有能力对相关内容进行控制/删除,并参与对未经合规标识生成合成内容的编排和推广[23]。根据《标识办法》第6条,信息管理平台主要负担协助义务、提示义务、核验义务与标识义务4类,可部分归属于平台数据安全保障义务,且与信息管理平台6个相关业务管理流程相对应(见表2)。本文所讨论的信息管理平台标识义务为广义标识义务,即与标识生成合成内容相关的义务,并不仅仅局限于信息管理平台自身进行补充标识的狭义标识义务。

表2 信息管理平台标识义务类型与业务管理流程

Table 2 Types of identification obligations and business management processes in the information management platform

义务类型标识义务相关业务管理流程协助义务提示义务①为用户提供声明“发布内容是否包含生成合成内容”的功能,并提醒用户主动声明发布内容中是否包含生成合成内容核验义务②核验文件元数据是否包含隐式标识③检测传播内容是否包含显式标识④检测传播内容是否包含其它生成合成痕迹、识别疑似生成合成内容标识义务⑤对于可能包含生成合成内容的,在文件元数据中添加生成合成内容属性信息、传播平台名称或编码、内容编号等传播要素信息⑥对于根据元数据核验、用户声明、平台检测等发现可能包含生成合成内容的,添加相应显式标识提醒公众

(2)信息管理平台标识义务流程解释。表2中流程①同时包含协助义务和提示义务。协助义务包括协助用户发布提供声明“发布内容是否包含生成合成内容”的功能,通过与用户形成合力,引导用户自主声明生成合成内容,从生成端源头作出标注,能有效降低后续传播环节的标识成本。例如,当前“小红书”“抖音”等信息管理平台在发布用户内容时,均可由用户发布生成合成内容声明。

提示义务包含的核心内容为:其一,根据《标识办法》第10条第2款,明确告知用户在使用生成合成内容时,禁止恶意删除、篡改、伪造、隐匿法定标识,不得为上述行为提供工具或服务,不得通过不正当标识手段损害他人权益。其二,明确告知用户在发布生成合成内容时,对于可能造成混淆或误认的情形应当进行显著标识,并鼓励用户对生成合成内容进行实质透明化信息披露,如说明“人机共创”各自的具体贡献、生成合成内容可能存在编造案例或数据的可能性等。未来对“显式标识例外”的解读优化,可依据内容安全风险对显式标识义务的履行进行情境限缩。

表2中流程②③④主要涉及核验义务,要求核验文件元数据中是否包含隐式标识、检测传播内容是否包含显式标识和其它生成合成痕迹、识别疑似生成合成内容。流程⑤⑥主要涉及标识义务,要求对于可能包含生成合成内容的,应在文件元数据中添加隐式标识,在发布内容周边添加显著提示标识。这意味着,信息管理平台纵使自身并不提供人工智能生成合成服务,仍应具备相关隐式标识、显式标识、生成合成痕迹检测技术以及隐式标识技术,否则有可能面临合规风险。

(3)应用程序分发平台标识义务规定解释。根据《深度合成规定》第13条、《标识办法》第7条规定,互联网应用商店等应用程序分发平台应落实上架审核、日常管理、应急处置等安全管理责任,核验深度合成类应用程序的安全评估、备案等情况;对违反国家有关规定的,应及时采取不予上架、警示、暂停服务或者下架等处置措施。在应用程序上架或者上线审核时,应要求互联网应用程序服务提供者说明是否提供人工智能生成合成服务。对于互联网应用程序服务提供者提供人工智能生成合成服务的,互联网应用程序分发平台应核验其生成合成内容标识相关材料。此处规范罅隙在于,《标识办法》第7条仅要求应用程序分发平台对“提供人工智能生成合成服务”的服务提供者核验其生成合成内容标识相关材料。然而,纵使自身不提供生成合成内容服务的信息管理平台,也需负担核验义务和标识义务,并具备标识技术和检测生成合成内容技术,即核验文件元数据中是否包含隐式标识、检测传播内容中是否包含显式标识等。现行规范赋予应用程序分发平台的监管义务有所侧重——仅要求针对生成合成服务提供者而非信息管理平台进行监管。这可能是为避免给应用程序分发平台带来沉重的监管负担,以及适度弱化信息管理平台的标识义务,给予其完善标识技术的缓冲时间,避免其不具备相应技术信息管理平台而直接丧失在应用商店上架自身程序的基础资格。

3.2.1 显式标识例外的既有解释及其问题

对《标识办法》第9条“显式标识例外”的理解,除直接关系到用户显式标识义务应如何履行外,也直接影响服务提供者应如何提供生成合成内容,以及信息管理平台应当如何履行补充标识义务与核验义务。履行显式标识义务的前提是,根据《深度合成规定》第17条“可能导致公众混淆或者误认”。此外,服务提供者可“在通过用户协议明确用户的标识义务和使用责任后,提供不含显式标识的生成合成内容,并依法留存提供对象信息等相关日志不少于六个月”。而如何解释“可能导致公众混淆或者误认”以及“显式标识例外”中“明确用户标识义务和使用责任”的具体内涵,则是服务提供者与信息管理平台标识义务解释的核心难点。

《标识办法》第9条旨在充分考虑生成合成内容在实际场景中的落地应用,积极回应社会关切和产业需要,允许服务提供者附条件地对于可能导致公众混淆或者误认的生成合成内容不进行显式标识。用户在依据第9条申请服务提供者提供没有添加显式标识的生成合成内容时,通常并不希望他人知晓相关内容涉及人工智能生成合成,或认为标识在传播和使用过程中会影响美观性。矛盾之处在于,“用户在后续使用过程中,需遵守《标识办法》第10条等相关要求,主动声明生成合成内容并添加显式标识,方可面向公众发布和传播”[13],且根据《标识办法》第6条,信息管理平台应针对所有可能造成混淆或误认的生成合成内容履行补充标识义务。

此种解释路径可能会违背标识制度功能限度论下,对于保障功能实效最大化、降低实施成本的阐释原则,过度泛化的生成合成标识会弱化信息披露效果。同时,在任何面向公众发布和传播的场景中,若需要对生成合成内容进行显式标识,可能产生大量监管成本、纠纷解决成本,以及因显式标识带来“人机共创”场景下内容应用的不便利,甚或因存在人工智能生成合成参与而导致内容价值、流量的贬损。

3.2.2 信息管理平台标识义务的优化路径

(1)协助义务与提示义务优化路径。表2中流程①存在的问题为:首先,提醒声明不到位,交互路径冗长。以某短视频社交平台为例,软件并非在发布页面以弹窗或直接呈现形式显著提示用户,而是在发布页面点击2次交互按钮后,方可查看生成合成内容标识。其次,声明内容设计粗放。其一,未充分呈现人工智能贡献度等信息,忽视了用户或其他主体的创作比例。标识未呈现人工智能贡献比例,可能导致用户不愿意进行标识,从而不利于著作权的充分展示。因此,未来应充分保障公众对人工智能贡献度的知情权[24]。其二,未区分疑似或确信等程度选项。用户发布内容很可能涉及对他人素材的再次加工,未必能对生成合成内容予以准确表述,导致标识意愿与准确性受限。其三,未提供其他用户的协助标记选项,不利于充分发挥平台共治合力。未来需通过强化显著提示、细化声明要素、引入多元标注机制,在落实协助义务的同时,保障公众对生成合成内容的知情权,构建更精准的生成合成内容标识体系。

(2)核验义务与标识义务优化路径。表2中流程②③④规范的不足在于,《标识办法》第7条仅要求互联网应用程序分发平台在应用程序上架或上线审核时,要求服务提供者说明是否提供人工智能生成合成服务,若提供则需核验其生成合成内容标识相关材料,否则可采取不予上架等处置措施(《深度合成规定》第13条)。但前述规范分析显示,所有信息管理平台均应具备生成合成内容标识能力。因此,互联网应用程序分发平台对标识能力审查对象、范围及标准需进一步精细化。

3.2.3 信息管理平台内治理机制优化路径

对生成合成内容的隐式标识、显式标识以及信息网络平台检测的合成痕迹结果,均有可能存在因误认、删除、篡改、伪造、隐匿等情形而不准确的情况。当前,平台对用户内容、账户作出删除、限制等决定应遵循何种程序,在立法与监管实践中缺乏足够关注[25]。平台作为信息传播媒介,应对标识结果建立合理的申诉机制,以避免非人工智能生成合成内容被错误标识。例如,对于自动检测标识结果,允许用户再次申诉。在申诉通道中,根据用户反馈结果,对标识内容进行从“明确提醒公众该内容属于生成合成内容”到“提醒公众该内容可能为生成合成内容”再到“取消生成合成内容标识”等标识梯度调整。此外,根据《网络音视频信息服务管理规定》第14条,信息管理平台应善用与用户签订的服务协议。对于违反标识义务的用户,可依约采取警示整改、限制功能、暂停更新、关闭账号等处置措施,保存有关记录,并向国家网信办、文化和旅游、广播电视等部门报告,从而实现平台制裁的有效性。

实践中,已有因平台算法识别用户发布生成合成内容并作出制裁措施而引发争议的案例。原告为涉案平台用户,被告为涉案平台运营者,原告发布内容被平台判定为“包含AI生成内容但未标识”的违规情况,涉案平台作出将该内容隐藏的处理,后原告进行申诉未成功[26-27]。该案反映出当前平台识别生成合成内容未必准确,若在用户申诉后未有梯度式的补充标识处理,而是一律删除,可能导致生成合成信息治理与用户表达自由之间关系紧张。标识制度的核心目的在于保障信息透明度,因此相应损害填补措施宜符合比例原则,即“补充标识”通常即可满足治理需要,而“隐藏内容”宜作为多次违反标识义务后的制裁手段。在举证责任分配层面,该案裁判观点认为,若网络内容服务平台判定用户发布内容为AI生成,用户需提供证明该内容系人类创作的初步证据,若达到相应证明标准,则网络内容服务平台应举证证明其使用算法工具进行判定的正确性或进行必要限度的解释说明,不得仅以涉及商业秘密为由而规避该义务。

用户对自身创作痕迹的证明,以及平台对其算法判定正确性的证明,实际上皆可能并不容易,对于即时性创作文本场景而言尤其如此。纵使算法合理,人工智能生成内容检测也可能存在误差。平台规制过程中宜采用符合比例原则的处置方式,以补充“梯度标识”作为首选处理手段,实现信息透明化目标;以删除内容或限制账号发言、关闭账号等方式作为谦抑性制裁,慎用后用,由此避免因人工智能生成内容检测技术不完善而引发大量错误检测标识纠纷。

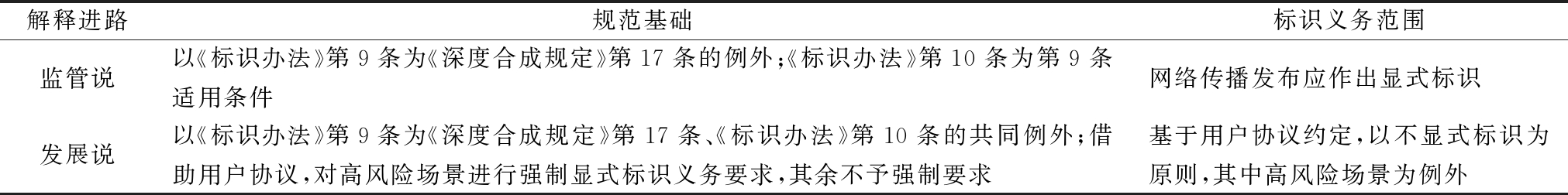

《标识办法》第9条显式标识例外的制度考量,旨在兼顾行业发展与风险防范。若将“可能致混淆时须显式标识”作为普遍前提,例外条款的适用条件将极为严格,其旨在提供的制度弹性与实际操作中的刚性要求之间如何协调,成为值得探讨的问题。对第9条的解释意义重大,未来需基于标识制度功能限度论,引入法经济分析思维,通过限缩显式标识范围,提升其实质功效,降低成本,避免标识泛滥。从法律文本看,《标识办法》第10条第1款及《深度合成规定》第17条分别对用户和服务提供者提出显式标识要求,前者限定于“网络信息内容传播服务”场景。《标识办法》第9条关于用户协议如何设定例外情形的“标识义务”,或成限缩显式标识义务的解释入口,相关解释包括监管说、发展说(见表3)。基于风险场景分类的“发展说”更为合理,能够激活“隐式标识+日志留存”机制,避免过严要求使例外规定沦为具文,为标识机制成熟化预留试错空间与合规灵活性。

表3 显式标识例外中用户标识义务两种解释进路

Table 3 Two interpretive approaches to user identification obligations in exceptions to explicit identification

解释进路规范基础标识义务范围监管说以《标识办法》第9条为《深度合成规定》第17条的例外;《标识办法》第10条为第9条适用条件网络传播发布应作出显式标识发展说以《标识办法》第9条为《深度合成规定》第17条、《标识办法》第10条的共同例外;借助用户协议,对高风险场景进行强制显式标识义务要求,其余不予强制要求基于用户协议约定,以不显式标识为原则,其中高风险场景为例外

根据“监管说”,《标识办法》第10条应理解为第9条“显式标识例外”的适用条件。纵使用户满足第9条显式标识例外适用条件,已经提出申请、添加隐式标识并日志留存,其在使用网络信息内容传播服务发布生成合成内容时,应主动声明并使用服务提供者提供的标识功能进行标识,但在其它非网络传播场景可豁免,由此使第9条“显著标识例外”条款发挥部分便利用户使用生成内容的功能。

例如,若学校教师利用生成合成内容制作自用教学课件,因未通过网络服务对外传播,无需启用服务提供者的标识功能;而将课件上传至网络课件共享平台或班级群(涉及信息传播服务),则需按规定声明并标识。再如,商家使用生成合成内容装饰实体店,因未接入网络传播服务,亦无需显著标识。该解释以“是否借助网络信息传播服务发布内容”作为义务分界点,精准划定用户在例外情形下的标识责任边界。这种区分显式标识义务的正当性在于,网络信息传播具有高速扩散性与公共风险敞口,基于传播场景是否涉网,差异化设置标识义务,能够针对性防范大规模误导、操纵等风险,构建社会公共信息信任体系。

“监管说”可能遭遇的质疑在于:其一,以是否涉及信息网络传播区分,与标识制度保障信息披露、防范安全风险的功能存在偏差。纵使并不涉及网络信息传播,依然会存在该生成合成内容的信息接收者,依然可能出现基于深度伪造技术制作的虚假政治、经济新闻。相关信息接收者仍有权知晓该信息是否由人工智能生成合成,以及知晓相关算法局限和错误可能性。其二,显著弱化了第9条显式标识例外的制度功能。过度普遍化的显式标识义务可能会弱化标识警示作用,使风险信息淹没在海量标识中,增大用户违反标识义务的可能性,致使用户倾向于隐瞒生成合成来源信息。其三,标识制度实施成本较高,未贯彻基于风险场景差异区分解释、控制标识成本的解释原则。

“发展说”则限缩了用户显式标识义务,基于标识制度功能限度论,围绕风险场景差异进行标识义务区分,缩小了显式标识义务强制履行场景,减少了相关制度实施成本和纠纷解决成本。该解释路径主张《标识办法》第9条构成第10条第1款与《深度合成规定》第17条的共同例外情形,即当用户申请服务提供者生成无显式标识内容时,可通过隐式标识及服务提供者6个月日志留存的兜底机制,免除其在使用过程中(含网络传播场景)添加显式标识的义务,但用户协议中明确的部分高风险场景不可豁免显式标识义务。

该解释路径是基于现行《标识办法》等标识制度规范体系所作出的权宜解释方案,且有赖于行政主管部门对人工智能生成合成风险场景的具体划分,以统一规范“用户协议”内标识义务和使用责任,对于高风险场景,规定强制显式标识义务。例如,用户利用人工智能自动生成含有现实人物及其行为、场景的视频可能引起混淆时,应以显著方式明确标注该视频借助人工智能技术生成。再如,涉及使用他人肖像,利用人工智能生成图片时,无论是否经由肖像权人同意,皆应显著标识该图片借助人工智能技术生成。相关强制显式标识义务内容可先由用户协议予以明确,未来随相关规范发布进一步统一。同时,根据前述显式标识义务范围,限缩信息管理平台履行补充标识义务的范围。

该解释路径的正当性在于:其一,产业发展导向。人工智能作为新一轮科技革命的核心驱动力,对经济发展与全球竞争力提升至关重要,显式标识要求可能会降低内容使用便捷性,从需求端抑制产业供给活力。欧盟委员会推迟《人工智能法案》部分核心条款的实施,是出于担忧加重监管成本和企业合规负担[28]。其二,标识功能保障。显式标识义务的普遍推行可能会削弱公众信息甄别的实质效果[17]。其三,标识机制尚未充分实质透明化,用户完全履行标识义务的现实可能性有限。例如,在使用生成式人工智能进行学术写作过程中,人机关系具有隐蔽性与混合性特征[29],“形式透明”的标识制度(即不解释人工智能具体贡献度的标识模式)无法充分进行信息披露[30]。当前并未普及展示人工智能贡献度的实质透明标识模式,将导致用户自身的学术贡献被弱化。

相较于“监管说”对显式标识的全面强制,“发展说”通过弹性规制平衡安全与发展的关系,避免将技术应用限制在“事事需贴标”的低效状态中。未来可进一步考虑从法律风险、技术难度、用户体验等维度精细化设置显式标识例外场景。例如,考量大语言模型生成文本与图片、视频的标识在技术难度和用户体验方面存在差异。尽管当前已有对AI生成文本添加水印的技术,且相关技术能够在保持文本质量的同时,提高水印检测率。例如,SynthID Text使用的Tournament Sampling采样算法技术已被应用于Google DeepMind的Gemini系统中,用于跟踪AI生成的文本内容,但SynthID Text和其它生成水印一样,容易受到窃取、欺骗和擦除攻击[31]。同时,可考虑取消对网络传播场景与非网络传播场景在显式标识义务上的差别规定,增加对用户恶意删除高风险场景下生成合成内容标识(显式标识、隐式标识)的行政处罚。

当前,对标识制度功能实效存在较高期待,导致监管范围有扩大倾向。我国标识制度实质透明化进展有限,生成内容标识易引发信息价值贬损、弱化人类共创者贡献、AIGC检测结果可能存在误差,致使用户和平台标识意愿受到负面影响。同时,生成内容标识存在功能局限,无法替代信息质量、真伪及著作权判断,且易被篡改,影响溯源监管功能的发挥。从成本收益角度看,若标识带来的社会福祉因“形式透明”和“水印篡改”受限,低于技术搭建、价值贬损、纠纷解决等社会成本,则难以证成制度正当性。“普遍违法”环境下,即使采取刚性处罚措施,其带来的社会效益也未必高于其治理成本。

推动标识制度长效发展,需确立法经济分析思维,以功能实效最大化为原则,对人工智能参与度和参与方式进行实质标注。要反思产品信息披露理论局限,强调多元主体协同履行标识义务。坚持成本控制的区分化解释原则,根据主体和风险场景差异调整要求,在低风险场景中可降低或取消显式标识。平台标识义务由行政机关监管,依托“法律—部门规章—国家标准—平台规范”四维框架,用户义务主要靠平台监管,平台需提供便捷工具和提示,建立符合比例原则的制裁与申诉机制。《标识办法》第9条解释在未来应考虑从“监管说”转向“发展说”。作为相关条款的共同例外,应对高风险场景强制显式标识,其余场景依据用户协议,可不作强制要求。

本研究的不足在于,未基于量化方法分析标识制度可能产生的成本与效益,仅从宏观层面指出在阐释标识义务范围时,应当考虑制度实施所耗费的成本类型、所产生的效益限度,并梳理其具体内容。未来应进一步完善关于人工智能生成合成内容标识制度施行效果的实证研究和量化分析,完善生成合成内容风险分级分类标准,完善标识义务行政处罚等罚则对平台及用户的具体规定。此外,进一步厘清生成合成内容标识与著作权、数据合理使用的关系。

[1] BISHOP L. A computer wrote this paper: what ChatGPT means for education, research, and writing[J/OL]. SSRN Electronic Journal, (2023-01-26) [2025-04-01]. https://scholarworks.indianapolis.iu.edu/server/api/core/bitstreams/3c9d37a5-cb95-427a-9bd3-23089b75cdd9/content.

[2] 张永忠.论人工智能透明度原则的法治化实现[J].政法论丛,2024,40(2):124-137.

[3] 张平.透明度原则在人工智能治理中的适用[J].数字法治,2025,3(1):20-27.

[4] 端利涛,李思瑞,张晴晴.“网红种草”广告标识披露监管的社会福利效应研究综述[J].东北财经大学学报,2025,27(1):41-53.

[5] 熊琦.著作权激励机制的法律构造[M].北京:中国人民大学出版社,2011.

[6] 张继红.生成式人工智能生成内容标识义务研究[J].法商研究,2024,41(4):187-200.

[7] 朱阁.“AI文生图”的法律属性与权利归属研究[J].知识产权,2024,38(1):24-35.

[8] MELISSA HEIKKILA. It′s easy to tamper with watermarks from Al-generated text [EB/OL].(2024-05-29)[2025-07-20].https://www.technologyreview.com/2024/03/29/1090310/its-easy-to-tamper-with-watermarks-from-ai-generated-text/.

[9] 黄尹旭.《人工智能生成合成内容标识办法》的规范功能与法律适用[J].法律适用,2025,40(9):136-147.

[10] 刘文杰.何以透明,以何透明:人工智能法透明度规则之构建[J].比较法研究,2024,38(2):120-134.

[11] 赵精武.论交互对话式人工智能服务提供者的注意义务[J].法律适用,2025,40(4):119-134.

[12] 应飞虎.论结果导向的信息披露[J].中国社会科学,2019,40(5):121-143,207.

[13] 中国网信网.《人工智能生成合成内容标识办法》答记者问[EB/OL].(2025-03-14)[2025-07-20].https://www.cac.gov.cn/2025-03/14/c_1743654685896173.htm.

[14] 张欣.生成式人工智能的算法治理挑战与治理型监管[J].现代法学,2023,45(3):108-123.

[15] 戴昕,张永健.比例原则还是成本收益分析法学方法的批判性重构[J].中外法学,2018,30(6):1519-1545.

[16] MATTHEW D, ADLER, ERIC A. Posner, new foundations of cost——benefit analysis [M].Cambridge: Harvard University Press, 2006.

[17] 周辉.网络平台治理的理想类型与善治——以政府与平台企业间关系为视角[J].法学杂志,2020,41(9):24-36.

[18] 张凌寒,贾斯瑶.人工智能生成内容标识制度的逻辑更新与制度优化[J].求是学刊,2024,51 (1):112-122.

[19] 丁晓东.著作权的解构与重构:人工智能作品法律保护的法理反思[J].法制与社会发展,2023,29(5):109-127.

[20] 李铭轩,文继荣.AIGC时代网络信息内容的法律治理——以大语言模型为例[J].北京理工大学学报(社会科学版),2023,25(6):83-92.

[21] 支振锋.生成式人工智能大模型的信息内容治理[J].政法论坛,2023,41(4):34-48.

[22] KEN ARCHER. Watermarks in preview in Azure OpenAI Service [EB/OL].(2024-09-24) [2025-02-09].https://techcommunitymicrosoft.com/t5/ai-azure-ai-services-blog /watermarks-in-preview-in-azure-openai-service/ba-p/4253344.

[23] 胡凌.平台视角中的人工智能法律责任[J].交大法学,2019,20(3):5-19.

[24] 陈俊凯.人工智能生成内容信息披露机制构建研究[J].中国科技论坛,2024,40(3):160-167,176.

[25] 赵鹏.从平台责任到合作规制——互联网规制模式转型及其正当程序规范[J].法商研究,2025,42(3):35-48.

[26] 袁建华.人工智能生成合成内容标识的司法审查规则构建——以“平台判定用户内容系AI生成首案”为例[J].法律适用,2025,40(9):121-135.

[27] “北京互联网法院”微信公众号.为何我的回答被平台判定为AI生成?法院:平台需对判定结果进行适度的解释说明[EB/OL].(2025-06-20)[2025-07-20]. https://mp.weixin.qq.com/s/XBCO8fYfynz5RDVWe6O30Q.

[28] Competition Policy International (CPI). Possible delay in implementing EU AI Act now formally on the table [EB/0L].(2025-06-10) [2025-09-23]. https://www.pymnts.com/cpi-posts/possible-delay-in-implementing-eu-ai-act-now-formally-on-the-table/.

[29] KNOTT A, PEDRESCHI D, JITSUZUMI T. et al. AI content detection in the emerging information ecosystem: new obligations for media and tech companies[J].Ethics and Information Technology,2024,2(1):1-14.

[30] 程睿,秦小红.生成式人工智能使用者的透明度义务——以ChatGPT介入学术论文创作为视角[J].学术研究,2024,68(3):14-18.

[31] SUMANTH DATHATHRI. Scalable watermarking for identifying large language model outputs[J].Nature,2024,634(8035):818-823.