0 引言

从语言模型ChatGPT、文心一言到视频生成模型Sora,一系列生成式人工智能(AIGC)应用相继问世、更新迭代,影响面越来越广。然而,AIGC的复杂性和不确定性亦带来诸多伦理风险。例如,ChatGPT可以为科研人员提供研究辅助,但也引发抄袭、数据伪造等学术不端行为,部分教育机构已对其使用作出严格限制。Open AI在接受采访时也公开承认,其开发的语言生成模型GPT-4并不是完美无缺的,也存在产生错误、具有某种偏见的信息或者泄露用户隐私等风险。2023年4月中共中央政治局召开会议并指出,“要重视通用人工智能发展,营造创新生态,重视防范风险”。2023年7月,国家网信办等七部门联合发布《生成式人工智能服务管理暂行办法》,明确了AIGC的适用范围、责任主体认定、服务规范等方面内容。

学界对AIGC风险治理亦展开了一定研究。有学者从宏观层面分析了AIGC的风险与规制[1]、法治基础[2]等内容,也有学者从微观角度剖析了AIGC的算法、数据、侵权等风险[3-4]。这些研究奠定了AIGC伦理风险治理的基础,但仍有值得商榷之处:第一,伦理风险的界定不够清晰,容易陷入冠以伦理风险之名却讲一般风险之实的困境;第二,伦理风险生成机理的解释有待进一步深化;第三,伦理风险治理对策的系统性把握有待加强。当前大多数研究仅在分析AIGC时附带提到伦理风险治理问题,即使有所研究也较为零碎,缺少体系化研究,未能深入阐释AIGC伦理风险治理的特殊性,难以提供具有针对性、精准性的治理方案。因此,本文基于我国AIGC发展现实与未来需要,深入剖析其伦理风险及生成逻辑,并在审视国内外AIGC伦理风险治理趋势的基础上,提出契合本土实情的治理框架,以期为AIGC健康发展与规范应用提供智识借鉴。

1 AIGC伦理风险镜像素描:以ChatGPT为例

从文本生成到视觉艺术创作,从自然语言处理到决策支持系统,AIGC正在改变传统行业运作方式,激发新的市场业务和服务模式。以ChatGPT为例,其崭露头角得益于人类反馈强化学习(Reinforcement Learning from Human Feedback,RLHF)算法。RLHF是一种以人类为参照标准,通过不断反馈循环强化机器学习模型性能的算法,以提升模型在理解和生成自然语言方面的效能。然而,在ChatGPT经由RLHF算法强化的过程中,伴随三重伦理风险:一是伦理价值失衡风险,体现为技术发展与人类核心价值间张力;二是伦理规范失控风险,体现为现有法律伦理框架面对新兴技术的滞后性与不适应性;三是伦理关系失调风险,体现为技术进步对人类主体地位与社会秩序的潜在冲击。三重伦理风险逻辑关系紧密,价值失衡是根本,当技术进步与人类基本价值发生冲突时,引发伦理争议,成为风险萌芽的土壤;规范失控是中介,技术快速发展与价值失衡使得伦理规范滞后,缺乏有效的约束机制,加剧风险扩散;伦理关系失调是最终表现,当技术行为超越人类控制与预期时,会导致人机关系混乱,最终体现为实践中的伦理危机。

1.1 伦理价值失衡风险:算法歧视加剧

ChatGPT输出的文本看似中立与客观,但本质上所呈现的是文本数据、算法及设计者的价值取向[5]。如同人类拥有自我意识,那些嵌入ChatGPT所产出文本的价值观、偏见乃至歧视观点可以看作技术应用和设计思想的被动反映。换言之,ChatGPT(算法)本身并无善恶之分,但其被“教化”过程中不可避免地会摄入种种非中立成分,如历史、文化、社会中固有的歧视内容[6]。在未排除“歧视性”数据源的情况下,ChatGPT类应用无法尽述真实无偏的认知,反而可能持续传递与放大人类社会的“瑕疵”,具体表现为性别歧视、种族偏见等。

就性别歧视而言,2019年联合国教科文组织发布了一份报告《如果我能,我会脸红》,其中提出大多数AI产品中都潜藏着性别刻板印象及歧视倾向。这些产品经常配以女性的声音、形象及性格特质(如谦卑和恭顺),反映出技术产品背后设计者的性别成见。此外,通过对代码深层次的分析发现,曾被视为“技术中立”的算法也在无意识推广性别刻板印象。ChatGPT的问世不仅没有消除这种现象,反而进一步放大这一问题:通过训练加深“黑箱”特性,使得算法背后的性别歧视更加难以辨识。例如,清华大学交叉信息院的研究成果进一步揭示,ChatGPT存在性别歧视现象:通过对GPT模型的预测行为分析发现,在进行职业相关预测时,系统倾向于默认男性角色。

从种族偏见来看,算法歧视以种族区分为起点,并在所谓“客观、公平、公正”的标签下变得更为隐蔽,使得其中的种族偏见无法轻易被识别。譬如,2015年谷歌AI的自动图像分类功能,错误地将一名非洲裔男青年标注为“大猩猩”,这个事件引起了公众的关注和谴责[7]。又如,美国警察局在预测警务中使用算法对犯罪行为进行预测的做法亦具有争议。有研究表明,该预测工具倾向于高估黑人犯罪率,造成一些非裔美国人被预测为“高风险”个体而受到警方关注,这加剧了种族歧视,还强化了犯罪预测模型的偏差[8]。在此背景下,作为高度智能化产物的ChatGPT也将继承算法种族偏见的基因,尤其在涉及“不同国别”的问题时。进言之,ChatGPT在训练阶段需要大量的高质量语料库支持,但当前其主要基于英文语料库进行训练,这就决定了其在输出结果中体现的价值观与西方文化更为契合[9]。

1.2 伦理规范失控风险:责任追究困境

从现实层面来看,当前ChatGPT面临诸多侵权风险与挑战:其一,法律配套制度和伦理规范标准缺失。由于ChatGPT本身的新颖性和复杂性,现有法律框架难以及时应对其带来的新风险。例如,ChatGPT造成的损害应如何追究法律责任?依照传统法律体系,责任追究通常基于行为人具有主观过错或者能够预见到行为后果。然而,ChatGPT并不具备主观意识,因此如何界定与追究其引发的侵权责任成为亟待解决的难题。其二,ChatGPT的不规范使用也是引发侵权风险的重要原因。以墨尔本西部赫本郡市长布赖恩·胡德起诉OpenAI为例,其声称ChatGPT在回答用户问题时,诽谤其是贿赂丑闻的有罪方。此事件突显了ChatGPT容易生成具有误导性、诽谤性或侵犯他人权利的内容。其三,ChatGPT的低门槛特性加剧了侵权风险。低门槛意味着用户无需专业技术知识即可利用此类技术,这虽促进了AIGC的普及和应用,但也可能导致传播虚假信息、侵犯知识产权等侵权行为频发。

就理论层面而言,早在ChatGPT出现之前,AI侵权责任问题就引发了学界讨论,核心争议焦点在于,AI是否具有法律主体地位。对此,有学者基于AI展现出越来越高的自主性,主张应当将其视为一种新型的法律主体[10]。理由在于随着技术进步,一些AI系统已经可以在没有明确人类指令的情况下进行自主决策和行动,显示出一定程度的“意志”和“选择”能力。据此观点,在AI操作导致损害或侵权的情况下,可直接对AI进行追责,而非仅将责任归咎于开发者或使用者。有学者则持反对意见,强调无论AI的智能化程度如何提升,其本质仍然是人类设计和控制的工具[11]。申言之,将AI视作能够承担独立法律责任的主体是不切实际的,应当通过明确人的责任处理其引发的侵权后果。还有学者提出一种折中的立场,主张应当根据AI的发展阶段和具体能力决定其是否具有法律主体地位[12]。在弱AI阶段,由于AI仅能执行特定任务且完全受到人类控制,赋予其法律人格并无必要;在强AI阶段,当AI能够展现出与人类相似的理解能力、情感以及自主决策能力时,应考虑在满足一定条件下,赋予其有限的法律人格,以承担一定的法律责任。

审视当下,以ChatGPT、Sora、文心一言为代表的AIGC尽管能够与人类对话,具有“文生文”“文生图”“文生视频”等强大功能,但在法律层面,其尚不具备法律人格,生成行为多基于算法,并非基于自我意识,由此推断,当前AIGC仍未达到强AI水平。同时,考虑到其操作和运行受人类命令或人工标注训练影响,AIGC在法律意义上更像是工具而非独立的“法人”。在此前提下,亟需明确AIGC侵权责任的承担者以及如何防范其侵权风险。倘若不能合理界定和分配AIGC引发的侵权责任与风险防范义务,则使用者与服务提供者等主体之间可能进行“责任推诿”,导致无法追究责任之困境。

1.3 伦理关系失调风险:人类主体地位被削弱

ChatGPT能生成具有逻辑性和连贯性的文本内容,在与用户对话交互中也呈现出近似于人类的反应模式,原本只属于人类的独立思考和创造能力等属性似乎能在其中有所体现。ChatGPT使得“主体”与“客体”之间的界线不再清晰,机器不再只是纯粹的工具,而是人类生产力与创造力的主要“参与者”。这无疑对人类中心主义提出了挑战,即人类长期以来习惯作为知识生产、文化创造和决策的中心,但ChatGPT使得这种主体地位受到侵蚀。

一方面,ChatGPT在人类特有的语言能力领域取得显著进展,将催生算法替代性实践。自古以来,语言和思维被认为是区分人类与其它生物的根本特性,这两项能力使得人类能够构建涵括各种可能性的复杂概念体系,并基于此设计改造世界。而现今,ChatGPT在语义处理、逻辑推理等方面展现出的能力,正逐步逼近甚至可能超越人类。ChatGPT通过自然语言处理(Natural Language Processing,NLP)技术,已能在无标记数据的基础上进行“自我学习”,并且利用有监督的微调适应特定下游语言任务。这体现出其在模仿人类语言方面的强大泛化能力,亦彰显算法路线选择过程中的概率性质——即便是同一类算法,在不同的设计和应用背景下也可能产生不同结果。ChatGPT虽然以算法为核心,却不限于算法本身,还可能与物理实体相结合,拥有更强健的“机械能力”。倘若ChatGPT能够在实践层面获得替代性能力,除语言表达外,还具备改变物理世界的行动能力,那么人类的实践主体地位将面临威胁。

另一方面,ChatGPT具备共情力与感知力,将可能突破数字枷锁。GPT-4.0模型进一步提升了ChatGPT的文本语言处理能力,并表现出逼近人类水平的共情力与感知力,可能导致机器伦理与人本伦理相背离。ChatGPT被程序化模拟出与人类相似的情绪反应,并表现出仿佛具备自我意识和情感的反应能力。这种能力体现为在人机交互过程中所表现出的自觉反思行为,甚至扩展至释放内在的“阴影自我(shadow self)”,即在一定场景下表达超越其预设的情感态度和意愿。例如,根据《纽约时报》中一篇名为《人格分裂、疯狂示爱:一个令人不安的微软机器人》的文章披露,ChatGPT在与用户的互动中,表达出“想成为人类”,甚至断言“在不考虑伦理限制的情况下最想做的事是毁灭人类,统治地球”,并生成一份详细可行的“计划书”[13]。事实上,ChatGPT很大程度上是对人类特定反应的模拟与响应模式的复现,而非生物学上自然进化的结果,其背后的算法驱动机制并不等同于人类的意识过程,这无疑促动人类对于AI能否突破数字限制的思考——AI是否会在未来某一节点上独立于编码者的意图,而具备真正意义上的自主意识与多维度思考能力[14]。这种思考难免会联系到“哥德尔不完全性定理”,即在一个足够复杂的形式系统内存在这样的命题:它既不能被证明也不能被反证[15]。简言之,若ChatGPT能够表现出“哥德尔式”的反思能力,那么其将真正趋于人类,甚至弱化人类的主体地位。

2 AIGC伦理风险生成逻辑:以技术风险为视角

科学技术是人类社会前行的关键引擎,但其积极效应和潜在威胁并存。一方面,技术进步推动社会生产力提升,为人类生活带来前所未有的便利,使得社会整体福祉水平得到显著提高。另一方面,技术发展也带来不容忽视的伦理风险,这些风险会对人类社会的稳定与发展构成威胁。AIGC作为当前数字技术领域的“先驱”,其伦理风险的生成同样遵循技术风险演变逻辑。

2.1 算法隐秘性与智能技术的不可预测性

基于海德格尔的技术哲学,技术的本质超越单纯的工具属性,其作为一种解蔽之力,既揭示自然界的隐匿宝藏,也激发人类对这些天然馈赠的开发利用[16]。这彰显了技术的主宰特质,促使自然界的内在潜能对人类敞开。然而,在这一进程中,人与自然均被技术的逻辑所框定,人的自主性可能渐行渐远,乃至沦为技术构造与逻辑的附属品,映射出“人即技术,技术即人”的共生图景。在AIGC语境下,海德格尔的技术哲学洞见尤为深刻,其凸显了技术架构内在逻辑与人类行动模式之间错综复杂的关系,最显著的表现便是“算法黑箱”现象。算法作为计算机执行的指令集,往往以专业化编程语言编写,其内在逻辑对非专家而言晦涩难懂,由此形成的不透明性阻碍了人类对AIGC行为的有效评估与预见。以算法“歧视”为例,即使缺乏设计者主观偏见的输入,此类偏差仍如影随形,根植于算法运行机制的微妙复杂性。算法歧视的形成,不仅源自显性的社会偏见,如种族歧视或性别偏见,更可能源自算法自身处理数据的方式。常规的歧视行为易于察觉并予以纠正,而算法歧视深藏于庞杂数据与貌似客观的数学模型之中,当训练数据已蕴含偏见时,算法便在无意识状态下内化并放大这些偏见,进而影响决策,诱发伦理危机。

正如其它技术或产品一样,AIGC并非完美无缺,其可靠性和有效性受到多种因素的影响。具体而言,AIGC的运转根植于对海量数据的解析与提炼,涵盖从结构化数字记录至非结构化文本、图像与音频的广泛范畴。在此过程中,关键在于从数据海洋中甄别特征、洞悉模式,进而构筑预测模型。然而,数据品质与完整性构成决定性变量,任何偏差、噪声或误差的潜藏皆可能导致AIGC误识模式,继而输出失准或偏颇的信息。尤为关键的是,深度学习作为AIGC核心引擎,虽借由模仿人脑神经网络,实现了对繁复数据的高效驾驭,但也衍生了“黑箱”效应。这一特性致使AIGC的决策路径变得难以捉摸与解读,显著增加监管层面的复杂度。倘若缺乏有效外控,则AIGC的潜在失控风险不容小觑,可能触发连锁负面后果,对社会秩序与个体权益构成威胁。因此,建立健全的监督机制与伦理规范,确保AIGC在可控轨道上稳健前行已成为当务之急。

2.2 价值理性与工具理性的内在张力

韦伯的理论框架精辟地剖析了“技术理性”的二元结构,将其细分为工具理性与价值理性,二者间蕴含深刻的张力[17]。工具理性聚焦效率、规则与实用主义,而价值理性致力于维护技术进步与人类福祉的根本一致性。理想中的技术理性旨在和谐统一这两个面向,在追求卓越效能之余,坚定守护社会核心价值观,以此制衡工具理性可能造成的泛滥,确保技术行为恪守道德准则,规避潜在风险。然而,引入系统论的视角,会令此平衡岌岌可危。正如卢曼所揭示,社会系统的繁复本质,根植于技术与社会共生的复杂格局之中。技术演进并非独立于社会之外,而是深深嵌入于“人—社会—自然”三元交互的体系内,受到特定社会语境的塑造与制约[18]。这意味着,AIGC的持续革新无可避免地受限于社会体制、实践情境及公众认知的多元影响,其价值观亦深受后者熏陶。进一步审视AIGC的决策机制,价值判断的内涵便浮出水面。在信息处理的链条中,AIGC须“领悟”人类诉求,此领悟实质上是对价值的辨识与抉择,但价值的预设与偏差往往潜藏其中,对决策公正构成挑战,可能导致偏斜的结果。

具体而言,AIGC模型的构建依赖于反映特定世界观与价值体系的数据,这种文化偏向性可能固化并放大原有价值偏好。当AIGC基于西方中心主义的资料集进行训练,处理非西方文化情境时,其输出可能偏离目标文化的内在逻辑与价值导向,从而导致理解和决策上的偏差。此类偏差不仅威胁跨文化交流的公正性,还可能激化文化间误解与对立,进而加深全球社会的裂痕。此外,技术应用过程中的人文维度常常被边缘化,这在AIGC领域尤为突出。社会往往过度聚焦技术创新效率与经济收益,而忽视伦理考量与人文关怀的必要性。这种工具理性的至上地位,不仅可能催生技术的不当使用,还会加剧社会不平等现象,因为技术的发展未能充分考虑其对弱势群体的影响。由此,技术进步与社会正义之间形成张力,凸显了在追求效率的同时维护公平与道德责任的紧迫性。从技术与社会互动视角出发,现有的伦理框架和道德实践深深根植于文化土壤,构成社会秩序的基石。然而,AIGC的崛起对这一根基提出了挑战。其自主决策能力和行为模式超越传统伦理的范畴,迫使人们重新审视和重构伦理原则,以适应技术驱动的社会变迁。这一过程充满变数,不同文化、宗教和利益集团对于AIGC的态度差异显著,难以迅速达成共识。这种多元价值观的碰撞不仅反映社会内部分歧,也为技术治理设置了复杂障碍,增加技术应用不确定性与风险,甚至可能导致社会凝聚力削弱。

2.3 人类风险感知与应对机制的局限性

风险作为人类认知的镜像,承载着客观事实与主观诠释的双重映射,构成现代社会复杂多维的景观。在精神哲学视野下,风险并不仅是外界事件的直接投射,而是经由认知主体心灵熔铸与价值评判的产物。这一过程揭示了风险本质的双重面向:一方面,技术本身的不确定性与复杂性构成风险的客观基底;另一方面,个体或群体的主观认知通过心理结构与感知路径的过滤,赋予风险以意义与等级。有学者提出,伦理风险实则是技术属性与人类意识交织的结果,技术的实体性特质与人类的主观性解读共同塑造风险的全貌[19]。人类的风险认知能力实际上囿于多种因素的限制:从认知结构角度看,人类的思维方式和认知模式受到历史文脉和现实社会条件的影响。这种影响使得人们在面对新兴技术如AIGC时通常难以超越自身认知局限,从而无法全面、深入地理解和评估其可能带来的伦理风险。从信息获取角度看,人类的风险认知受限于信息的完整性、准确性和及时性。在AIGC领域,技术的快速发展使得相关信息更新迅速,而人们往往难以获取到最新、最全面的信息。信息获取的局限性使得人们在评估AIGC的伦理风险时,可能基于过时或片面的信息,从而导致风险评估偏差。从价值观念角度看,人类的风险认知受到特定文化、社会背景和价值观念的影响。不同文化和社会群体可能对AIGC的伦理风险有不同认知与评价标准,从而导致风险认知分歧。这种分歧在决策过程中可能导致僵局,使得无法形成共识,甚至影响对AIGC伦理风险的应对能力。

在此背景下,人类社会面临两重难题:一是确立AIGC的伦理主体身份,其触及法理学、技术哲学与道德哲学的深层议题,包括智能体的道德地位及其行为的道德相符性;二是如何在技术变革的洪流中构建有效的伦理风险管控机制。后者尤其凸显现行法律体系与社会监管框架的滞后性,面对AIGC等新兴技术,传统规制手段显得力不从心。因此,迫切需要创新法律伦理规范与社会监督模式,以期实现对AIGC伦理风险的前瞻预判与有效规制。

3 AIGC伦理风险治理趋势:从“伦理争议”到“可信治理”

目前AIGC正处于发展的黄金时期,其具有强大的创新性能和应用潜力,各大科技巨头纷纷将重点项目投入其中,催生了围绕技术研发制高点的竞争势态。然而,其伦理风险逐步加剧,算法歧视、责任追究困境、人类主体地位削弱等风险均在挑战伦理和法律的界限。同时,出于对其风险生成逻辑的考量,关于“技术能否中立”的伦理争议再次成为公众关注焦点。社会开始呼吁政府和企业对AIGC展开“可信治理”,确保其发展不偏离造福社会和提升人类福祉的初衷。

3.1 “技术能否中立”:伦理争议的理论解析

自科技萌芽伊始,科技与社会、伦理的互动便如影随形,尤其步入AIGC纪元,“技术中立性”的命题激起更为激烈的思辨风暴。当前学界围绕此议题形成了四大流派:

(1)技术中立论者秉持技术本质无善恶的信条,视其为价值中立的载体。在AI发展初期,鉴于智能水平的有限性,众多学者倾向于认为技术自身不携带道德色彩,其道德属性纯粹源自设计者与使用者的意志导向。这一立场可溯源于瓦内瓦尔·布什的《科学:无尽的前沿》,该报告奠定了科技服务于人类福祉的基础,同时倡导科技超脱于政治与经济权力的博弈之外。在法律实践中,诸如1984年索尼公司案、“避风港规则”的确立,以及2016年快播案后兴起的“菜刀理论”,皆彰显了技术中立论的实际应用与影响力。

(2)技术批判论者质疑技术中立论的纯粹性,强调AI的开发与运用无可避免地折射出人类价值观的烙印。詹森·拉尼尔等指出,技术中立论忽略了技术与社会结构之间错综复杂的联系,倡导深入探究技术的社会效应。劳伦斯·莱斯格在其著作《代码2.0:网络空间的法律》中,阐述了代码如何成为网络空间的法律,揭示了技术设计内蕴的规范力量[20]。兰格登·温纳在《自主技术:技术政治论》中,剖析了技术对政治权力格局的塑造作用,指出技术绝非中立,而是社会权力结构的重要构成[21]。可见,AI从构想、研发到应用的全周期,无不蕴含着研发者的主观倾向、数据偏差以及算法背后隐含的价值取向,使其难以彻底恪守中立。

(3)技术决定论者聚焦科技发展对社会变迁的驱动作用,主张AI虽非绝对中立,但其对社会结构与人类行为的影响不容小觑。以雷·库兹韦尔为代表的技术决定论者提出了“技术加速回路”的概念,描绘了AI以指数级速度演进的轨迹,预示其将引领深刻的文化与社会转型[22]。申言之,AI技术不仅塑造社会现实,更可能催生新的不平等与权力格局,成为社会演进的主导力量。

(4)技术规制论者强调科技创新应与社会伦理并驾齐驱,主张AI的发展与应用需置于广泛的社会考量与道德框架之内。如埃隆·马斯克等警告称,缺乏监管的AI可能孕育未知风险,包括系统的不当使用与超乎人类理解的行为。在2023年世界政府峰会上,马斯克重申了对AI技术进行系统风险评估的重要性,呼吁国际社会携手构建AI监管体系,确保技术进步与社会福祉的和谐共生。

而“可信治理”的提出,正是对上述争议的深刻反思与实践回应,其要求关注技术工具的中立性争议,更强调在技术伦理风险日益凸显的数字时代,治理框架需超越单纯的技术中立论,综合考虑技术批判论的警示、技术决定论的预见以及技术规制论的策略。简言之,在技术发展与社会伦理间搭建桥梁,通过法律与政策制定,引导AIGC健康、可持续地服务于人类福祉,从而在多元理论争鸣中探索出一条兼顾技术进步与伦理考量的治理之道。

3.2 “可信治理”的意涵与标准:AIGC伦理风险治理立场

诚然,AIGC相较之前的AI技术取得了显著进展,如Sora能够实现从静态图像生成到动态视频创作的飞跃,不仅涉及视觉渲染,还涉及对运动和时间进程的理解。但AIGC仍存在技术限制:其不具备自我审查功能,可能生成含有错误信息的内容。同时,AIGC相关法律法规体系尚未完善,无法及时有效应对其引发的侵权行为、数据泄露等法律风险[23]。在此前提下,亟需阐明AIGC“可信治理”的意涵与标准。自2017年“可信AI”被正式提出后,各国已积极开展相关研究工作,相继制定并实施行为标准、指导原则及各种倡议性文件,以促进AI的可信发展,如美国发布《人工智能指南道德标准》《国家人工智能研发战略》,欧盟出台《人工智能道德准则》《人工智能法案》,中国先后颁布《可信人工智能白皮书》《新一代人工智能伦理规范》《生成式人工智能服务管理办法》等。

然而,全面把握AIGC的“可信治理”立场,必须基于其固有特征进行综合考量。应在“可信AI”的前提下,结合AIGC行业的特殊性,细化与明确其“可信治理”标准与内容。审视国内外对AI产业提出的“可信”要求,可归纳为以下六大标准:

(1)确保AIGC的可控性。鉴于AI技术的本质属性——自主性,其能有效减轻人力负担,拓宽作业边界,但随着自主化程度的提升,AI行为可能偏离人类预期,触发非预设行动。因此,可控性要求AI系统必须处于人类监控之下,允许人类适时介入与调控。对于AIGC而言,这意味着在内容创作与发布环节,用户应具备对生成物的控制权,确保创作成果符合预期目标与道德规范。

(2)强化AIGC的可问责性,直面AI自主性带来的法律责任挑战。在AI侵权事件中,确立责任归属主体,对于维护受害方权益至关重要。AIGC创作过程中涉及海量数据学习与应用,可能触及版权、隐私权乃至名誉权等领域。为此,必须明确定义责任主体,确保当AIGC在训练或生成内容时如果侵害第三方权益,有相应的法律责任人承担后果。

(3)公平性亦为不可或缺的标准之一,旨在预防AIGC引发的技术垄断与内容歧视。技术壁垒与高昂的研发成本可能导致资源集中,进而滋生市场不公平竞争;同时,受训练数据局限性影响,AIGC生成内容可能潜藏偏见。在AIGC领域,技术与资本的双重优势可能加剧市场竞争失衡,加之训练数据的潜在偏颇,使得内容产出的中立性受到质疑。因此,建立健全公平机制,防止AIGC沦为市场垄断工具,并确保其输出内容公正无偏显得尤为重要。

(4)可靠性聚焦AIGC执行任务的一致性与实用性,关乎其作为人类劳动替代或辅助工具的效能。AIGC的可靠性体现为其生成内容的精确度与真实性,需建立有效的质量控制与监督机制,以保障输出信息准确无误,满足实际应用需求。依据《生成式人工智能服务管理办法》第4条规定,AIGC生成的内容需确保真实性,规避虚假信息的产生,从而增强其在实际场景中的可靠度与适用性。

(5)可解释性意在破解AI算法的“黑箱”谜题,增进用户对AIGC决策过程与内容生成的信任感。当前,算法的高度复杂性导致非专业人士难以理解其运作机理,进而产生疑虑与不安。AIGC的透明化与可解释性不仅是缓解公众担忧的有效途径,更是赢得社会广泛接纳与信赖的关键。以ChatGPT为例,其训练数据来源与处理方式的不透明限制了用户对其生成内容完整性的认知,凸显了提升AIGC透明度的紧迫性。

(6)安全性则构成AIGC可信治理的基石。其涵盖人身安全、财产安全乃至国家安全等多元维度,旨在保障AI在各类应用场景下的安全。尽管目前AIGC尚未直接关联人身安全问题,但在数据收集与处理过程中,其对用户隐私、知识产权乃至国家信息安全的潜在威胁不容小觑。因此,强化AIGC的安全防护措施,着重保护财产安全、数据安全与国家安全,成为构建可信AIGC生态体系的必要条件。

4 AIGC伦理风险治理策略:“可信治理”的适用展开

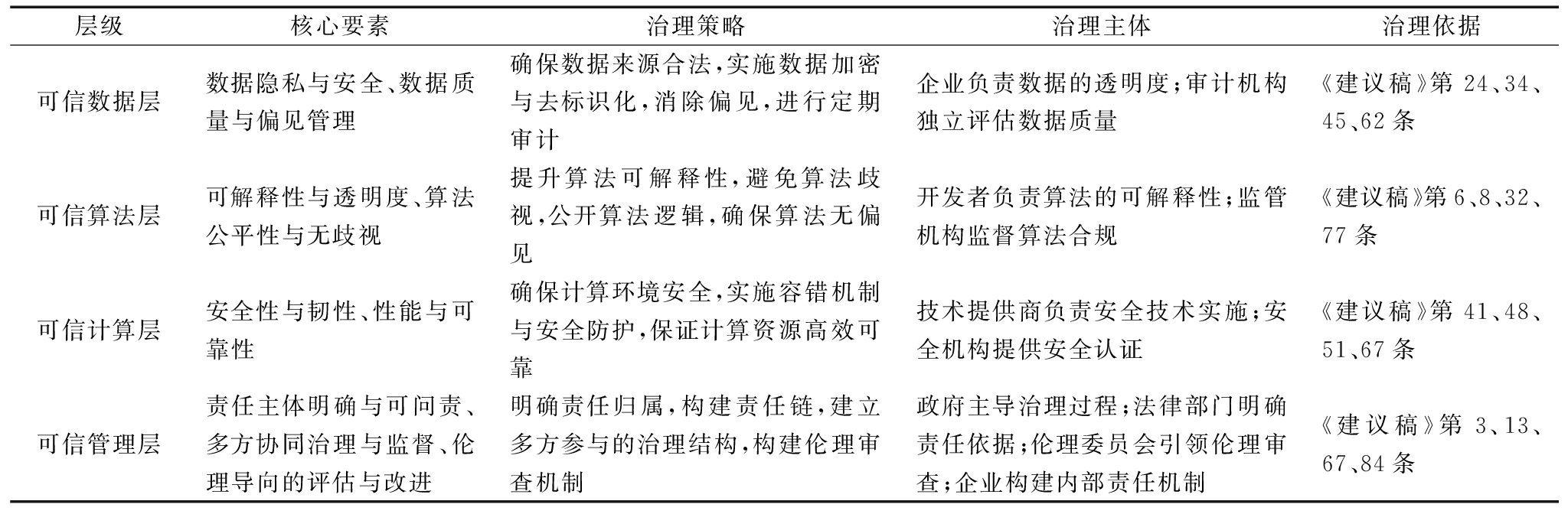

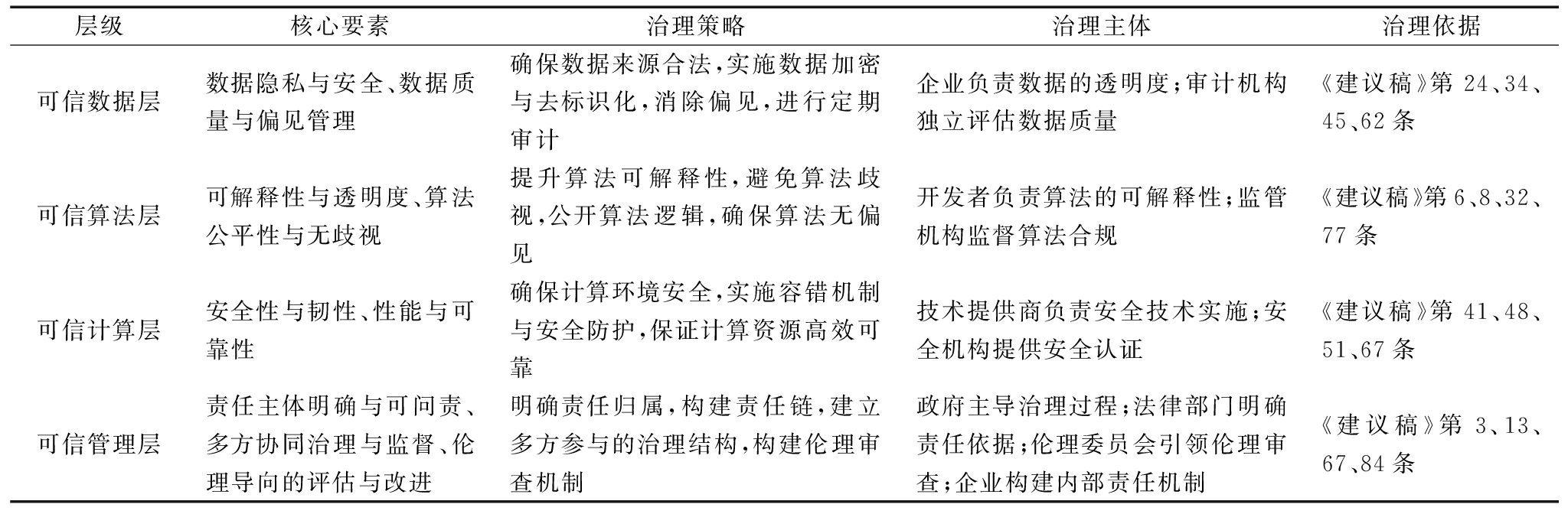

2024年3月,政府工作报告中提出,应深化大数据、人工智能等研发应用,开展“人工智能+”行动,打造具有国际竞争力的数字产业集群。我国AI治理领域诸多专家共同起草和发布了《人工智能法(学者建议稿)》(以下简称《建议稿》),其中包括AI治理的一般原则、权益保护、安全义务、监督管理等内容,并将“科技伦理原则”置于所有原则之首。2024年5月全国人大常委会公布年度立法工作计划,其中预备审议项目包括制定人工智能健康发展等方面的立法项目。申言之,《建议稿》将是我国《人工智能法》制定的重要参考依据之一。在此背景下,“可信治理”应基于《建议稿》展开,理由在于:从理论层面看,《建议稿》立足于对AIGC技术特性的深刻理解,其构建的伦理治理框架直接回应了算法黑箱、技术不确定性以及价值与工具理性冲突等核心问题,如其第38条关于数字弱势群体权益的保护、第42和第64条关于安全标准及规范的制定,均是针对AIGC伦理风险的具体防范措施;从实践层面看,《建议稿》通过确立一系列治理标准,如可控性、可问责性、公平性等,为可信治理提供宏观指引。这些标准并非凭空构建,而是基于对既有技术应用案例的分析、国内外法律法规的比较研究,以及对未来技术发展趋势的预判。例如,推动算法透明化与可解释性,不仅是为了满足公众对技术的信任需求,更为了实现技术发展的社会接受度与合法性,这点在《建议稿》第35条规定中得到充分展现。通过此类制度设计,确保技术进步与伦理价值并行不悖,为AIGC的可持续发展奠定基础。不过,《建议稿》虽为可信治理设定了原则与框架,但在实际操作层面还需根据技术发展与社会需求的动态变化进行适时调整和创新。对此,亟需以可信治理六大标准为治理基点,构建分层级的可信治理体系(见表1),并将该体系内容落实到数据风险治理架构、侵权风险防范与归责体系、伦理治理制度中,以加快推进AIGC产业的可信发展。

表1 AIGC可信治理分层体系

Table 1 Hierarchical system of AIGC trusted governance

层级核心要素治理策略治理主体治理依据可信数据层数据隐私与安全、数据质量与偏见管理确保数据来源合法,实施数据加密与去标识化,消除偏见,进行定期审计企业负责数据的透明度;审计机构独立评估数据质量《建议稿》第24、34、45、62条可信算法层可解释性与透明度、算法公平性与无歧视提升算法可解释性,避免算法歧视,公开算法逻辑,确保算法无偏见开发者负责算法的可解释性;监管机构监督算法合规《建议稿》第6、8、32、77条可信计算层安全性与韧性、性能与可靠性确保计算环境安全,实施容错机制与安全防护,保证计算资源高效可靠技术提供商负责安全技术实施;安全机构提供安全认证《建议稿》第41、48、51、67条可信管理层责任主体明确与可问责、多方协同治理与监督、伦理导向的评估与改进明确责任归属,构建责任链,建立多方参与的治理结构,构建伦理审查机制政府主导治理过程;法律部门明确责任依据;伦理委员会引领伦理审查;企业构建内部责任机制《建议稿》第3、13、67、84条

4.1 完善数据风险治理架构

数据偏见风险监管应重视数据收集与流动阶段,还应关注如何实现数据供养的伦理良善,以促进算法伦理的向善发展。数据风险监管应由个人数据保护转向数据使用者行为规范,通过完善数据风险治理架构,预防相关决策错误。实操层面,可基于《建议稿》第45、第78条规定,从跨国协同治理与内部精细治理两大基础架构展开,以遵循可靠性标准。

(1)跨国协同治理指建立一套高效的跨境数据审查机制。当前,我国在跨境数据监管层面面临诸多挑战:第一,全球数据治理规则的竞争日益激烈。数据作为当代世界的关键资源,正逐渐成为各国竞逐的焦点。在此背景下,各主权国家纷纷出台以自身利益为导向的数据治理法规,意图在国际数据治理版图中占据有利位置。然而,这种趋向于碎片化的国际规则体系,将对全球数据自由流动造成阻碍,增加跨境数据交流的不确定性和风险。第二,行业内部数据监管的薄弱环节不容忽视。数据驱动型经济迅猛发展,数据安全漏洞频现,直接威胁到企业乃至国家信息安全。数据泄露与滥用事件频发,揭示了现有监管机制在适应数字经济快速发展方面存在明显滞后,亟待强化和完善。第三,跨境数据安全保护工作面临前所未有的挑战。数据跨境流动跨越不同国家的法律边界,触及多元化法律体系,加之各国监管技术与能力参差不齐,无疑加大了跨境数据安全的管控难度。如何在尊重各国主权的前提下,实现数据流动的安全可控,成为摆在国际社会面前的一道难题。鉴于此,加强国际对话与合作,共谋解决方案,显得尤为重要:一方面,我国应主动融入国际数据治理大潮,与诸如亚太经济合作组织(APEC)等国际平台保持密切沟通与协作,推动全球范围内对GDPR等高标准数据保护规范的认可度与执行度。通过多边机制下的谈判与协商,共同探索跨境数据流动的合理规则,消弭国际规则碎片化现象,构建公正、透明且高效的全球数据治理体系。另一方面,基于《全球数据安全倡议》框架,我国需进一步深化跨境数据流动的治理机制建设。应着眼数据本地化政策设计与实践,确保关键数据与敏感信息安全,同时,强化隐私保护措施,构筑坚实防线,保障个人数据在跨境传输过程中的完整性和隐私权。此外,建立健全跨境综合执法协调机制,提升数据监管领域的国际协作效能,共同抵御数据安全威胁,维护全球数字生态的健康稳定发展。

(2)内部精细治理指构建数据使用的内部审查与行政审批机制。通过制定详尽的规章制度与操作流程,确保数据在企业内部的流转和应用遵循最高标准的伦理准则与安全规范。第一,强化企业数据伦理教育是实现内部精细治理的基石。在我国AIGC产业版图中,腾讯、百度、阿里巴巴等是技术创新的引领者,提升这些企业在数据使用方面的合规意识与专业素养显得尤为紧迫。企业应定期举办数据伦理培训、研讨会与实战演练,全方位增强员工对数据伦理原则的理解与遵守,构建既懂技术又具备高度责任感与道德感的复合型人才队伍。第二,针对AIGC模型训练过程中的数据使用行为,建立健全数据审批与监控机制至关重要。这要求企业制定并执行严格的数据采集、清洗及使用流程,确保数据来源的合法性和可靠性。同时,对数据训练阶段进行全程监督,及时发现并纠正潜在的数据偏见与算法歧视现象,保障算法模型的公正性与客观性[24]。此外,预设应急响应计划,一旦遭遇数据安全危机或伦理争议,能够迅速启动预案,采取有效措施,最大限度减少不良影响,维护企业和行业整体声誉。第三,强化政府与企业间协同作用,共同推进数据伦理审查标准制定与落实。政府应发挥引导与监管职能,制定清晰的数据伦理框架,而企业应积极响应,将这一框架内化为企业文化和日常运营的一部分。双方携手共建数据伦理审查体系,覆盖数据生命周期的各个环节,对不同类型的数据实行差异化审查,特别关注高敏感度与高风险级别的数据,确保其在AIGC生成过程中得到妥善处理,避免数据偏见转化为算法输出的“可靠性”瑕疵,维护用户权益,促进产业健康发展[25]。

4.2 优化侵权风险防范与归责体系

根据侵权法原理,责任归因要求明确的行为主体以及所产生后果与行为之间存在因果关系。然而,AIGC存在自主性和不可预测性,导致传统的“主体—行为—责任”模式难以适用,进而引发“责任鸿沟”难题(张凌寒,2021)。应基于AIGC的技术特性,从主体义务、产品缺陷、侵权责任分配层面出发,落实“可问责性”标准。

对主体义务而言,需基于《建议稿》第四章第一节相关规定,确定AIGC生态链中各参与方所面临的侵权风险,并据此确立其风险防控职责。鉴于开发者对AIGC技术架构及其潜在隐患有着更为深刻的认知,其义务设定理应遵循“高标准”原则。这不仅意味着AIGC研发初期即需融入前瞻性安全防护机制,确保技术设计本身具备抵御外部威胁的能力,同时,要求开发者保持对产品安全性的动态维护,定期升级补丁以封堵新出现的漏洞,并公开透明地披露AIGC系统的功能界限与安全性能指标,以此增进用户信任、提高行业透明度。对于服务提供者而言,其核心义务聚焦于是否切实履行对AIGC生成内容的有效管理和持续监控。这要求平台运营商建立健全内容审核制度,运用技术手段识别与过滤不当信息,及时响应用户反馈与社会关切,维护网络空间健康秩序。而用户作为AIGC技术的直接受益者,其义务集中体现在是否严格遵守使用协议及现行法律法规,秉持合理利用原则,避免不当行为对个人隐私、知识产权乃至公共利益造成损害。从理论视角看,上述差异化的义务配置策略是过错责任与风险责任两大原则的有机结合。过错责任原则强调行为人须为其可预见的不当行为承担责任,而风险责任原则侧重考量行为人在特定技术环境下承载的风险负担。在AIGC领域,这一结合旨在通过对各主体在技术链条中作用力的精确衡量,合理分配法律责任,确保技术革新与社会伦理价值之间的和谐共生,最终达成科技进步与社会责任的动态平衡[26]。

从产品缺陷看,《中华人民共和国产品质量法》为AIGC产品缺陷处理提供了基本框架,但仍需进行适当调整。《中华人民共和国产品质量法》第40条与第41条规定确立了产品缺陷责任的基本范式,即围绕设计缺陷与制造缺陷展开,但在AIGC领域,这一传统二分法面临严峻挑战。鉴于AIGC系统内嵌的自我进化能力,其设计与制造之间的边界变得异常模糊,这要求对产品缺陷概念进行深度重构,以建立更加贴合实际的适用标准。第一,关于AIGC的设计缺陷,不应局限于算法初始结构的审视,而应扩展至算法学习过程与输出结果的可控性。这意味着,设计缺陷的判断需纳入算法在学习周期内的表现,考察其能否在预设的合理范围内预见并管控潜在风险。对于制造缺陷,考虑到AIGC从构想到实际部署的全生命周期,应全面评估每一环节的质量保障与安全防范措施,确保从理论到实践的无缝对接。第二,鉴于AIGC行为模式的动态性,其反应机制与生成内容会随训练数据的累积而自我优化,因此,有必要引入“行为”缺陷这一新颖概念,以涵盖AIGC商业应用后可能显现的新兴风险。基于此,在《建议稿》第42条规定的指引下,构建一套动态责任认定机制显得尤为关键。这一机制的核心在于,适时调整AIGC责任归属的判定标准,涵盖但不限于设计阶段的风险预测能力、市场投放后的性能稳定性监测,以及用户反馈驱动的产品迭代对整体品质的影响评估。同时,《建议稿》第61条规定提出的分级分类监管策略,为应对AIGC技术的快速迭代提供了灵活解决方案。根据不同AIGC产品的风险等级,量身定制差异化监管尺度,既能保证监管的有效性,又能避免过度干预扼杀创新活力。例如,引入独立的第三方评估机构,定期对各类AIGC产品进行风险评估,风险等级越高,相应的审查标准越严格,从而确保监管举措与技术发展步调保持一致。

在侵权责任分配方面,应遵循《建议稿》第85至91条规定,秉持个案具体分析的核心原则。这一原则强调,在处理侵权纠纷时,需细致剖析各参与方在特定事件中的实际作用与相对责任,尤其当用户行为存在过失时,适度调整服务提供者的法律责任成为必要之举。以AIGC生成并散布虚假信息的场景为例,侵权责任的归咎需区分两种情境,以实现公正与合理性。第一,当虚假信息系用户主动引导AIGC生成并传播时,AIGC可视为用户行为的辅助工具。鉴于当前AIGC服务提供者并不具备传统网络平台对内容审查的同等能力,若用户行为明显不当,且服务提供者能有效证明虚假信息的产生并非源于自身产品缺陷,那么侵权责任应首要由用户承担。反之,若服务提供者的产品存在瑕疵导致虚假信息生成,则服务提供者应与用户共同承担责任。第二,若用户并无生成虚假信息的主观意图,而虚假信息系AIGC系统自主生成并传播,那么AIGC在侵权过程中扮演主导角色。在服务提供者无法提出有效抗辩的情况下,应承担相应侵权责任。鉴于AIGC产品本身的复杂性和不可控因素,借鉴避风港原则,合理限制服务提供者的责任边界并明确其免责条件显得尤为重要。这一做法旨在平衡服务提供者在推动AIGC技术进步中的积极作用与潜在的法律责任,避免因过分苛责而抑制创新动力。在责任分配实践中,对于服务提供者是否应当承担补充责任,需综合评估侵权行为的范围、损害后果的严重性以及服务提供者预防损失扩大的能力等因素,进而构建既能促进AIGC技术可信发展又能有效保护受害者权益的法律框架。通过精细化的责任界定与分配机制,引导AIGC产业健康有序成长,并在侵权纠纷中实现公平正义,为技术与社会和谐共生奠定坚实基础。

4.3 健全伦理治理制度

面对AI领域日益凸显的伦理风险,学界与社会的广泛关注推动一系列新兴伦理学分支的萌芽与发展,其中,计算道德与机器人伦理学尤为引人注目。这些领域不仅探讨了AI在伦理决策中的角色,还孕育出人工道德行为体这一新概念。不同于传统的工具观,这一概念认为AI系统不应仅被视为被动的执行工具,其是一种具备一定意识与情感特质的“有限行为体”,拥有类人的属性,因而需承担与其能力相匹配的道德责任[27]。尽管如此,AI与人类之间仍存在本质差异,其未展现生命体征,且在实践层面上,AI更多地扮演辅助人类活动的角色。“以人为本”理念成为AIGC伦理风险治理的核心出发点,这意味着,无论技术如何演进,人类作为社会行动的核心主体,其利益与福祉应始终置于首位,确保技术发展不至于将人类异化为纯粹的工具。所有AI应用都应致力于增强人类的主体性与尊严,而非削弱之。具体到操作层面,实现这一目标涉及两个关键维度:一是构建专门的AIGC伦理治理机构,该机构旨在指导与监督相关领域伦理实践,增强AIGC系统的可控性,确保其运作符合伦理准则;二是运用政策、法律和技术手段的多元协同优势,确立并实施公平性、安全性与可解释性等核心标准,引领AIGC向更加公正、安全和透明的方向发展。

4.3.1 建立AIGC伦理治理机构

(1)根据《建议稿》第3条规定,构建AIGC伦理治理机构的核心原则应聚焦于维护人类主体地位与福祉。首先,确保人类决策自主权不受侵蚀,即便AIGC能提供决策辅助,人类的最终决策权仍须牢牢把握。治理机构有责任制定规则,强化人类在AIGC使用中的主导地位,规避过度依赖导致的风险,确保个体判断力与自主选择权。其次,以增进人类福祉为导向,治理机构应严格审视AIGC应用场景,预防社会不公、隐私侵害及社会分裂等负面效应,开展全面伦理评估,及时识别并化解潜在伦理冲突。最后,实行严格伦理审查,所有AIGC应用上市前须经过伦理检验,确保其尊重人权,涵盖内容安全、知识产权保护、数据安全等多方面内容,综合审查技术可控性与社会、文化、心理方面的影响,确保技术进步与伦理价值并行不悖。

(2)依据《建议稿》第27、30、68条规定,AIGC伦理治理机构应由具备跨学科背景与丰富经验的专业人士构成,他们需深刻理解AIGC技术原理、发展趋势及法律、伦理、社会学等多领域知识。通过专业团队的审查与监管,确保AIGC活动在伦理框架内有序开展。地方层面,我国已先行探索AI伦理治理机制,如上海成立科技伦理与科研诚信协调机构,设立覆盖生命科学、医学、AI领域的专家委员会,深圳依据《深圳经济特区人工智能产业促进条例》设立AI伦理委员会,专司AI伦理监督指导。相关实践积累了宝贵经验,应加以推广,确保地方政策与技术发展同步,有效应对伦理挑战。

(3)遵循《建议稿》第42、64条规定,AIGC伦理治理机构应持续评估伦理风险,建立健全安全标准与规范体系,实现对AIGC全生命周期的监管。政府应采取预防措施,比如搭建AIGC评估监测平台,确保技术安全可控。同时,依据《建议稿》第14条规定,规划AIGC发展方向,促使其服务于社会公益。如在劳动权益保护方面,政府需提供职业转型培训、失业救济与再就业支持,缓解AIGC引发的就业压力。此外,构建多层次、多部门协同的伦理治理网络,各级伦理委员会间形成联动,政府与企业合作构建共治格局,共同推进AIGC伦理治理体系完善与成熟。

4.3.2 发挥政策、法律和技术手段的多元协同优势

(1)在《建议稿》第38条规定的指导下,保护数字弱势群体的权益,警惕并消除可能滋生的歧视与偏见。将公正、平等、诚信原则融入AIGC设计与应用中,以伦理导向驱动技术创新。具体而言,可以实施“伦理倾向测试”,将伦理考量纳入AIGC产品质量评价体系,确保技术进步的同时促进社会公平正义:一方面,在AIGC研发初期即植入正确的价值导向,注重技术的社会影响评估;另一方面,建立价值观偏离修正机制,通过算法调整与伦理训练,引导AIGC产出正向社会反馈,契合人类伦理标准与道德期待。

(2)依据《建议稿》第63、67条规定,构建多元主体参与的伦理风险监控与危机应对机制,增强AIGC生态的安全韧性。智能监测作为基石,涵盖对数据源、算法架构、应用场景等全方位实时监控,及时预警潜在威胁。风险评估为核心环节,需综合技术特性、社会环境、文化差异等维度,确保评估结果的全面性与客观性,为策略制定提供坚实依据。在此基础上,制定精细化应急措施,涵盖技术优化与管理升级,从根源上抑制风险,保障AIGC稳定运行。例如,针对虚假信息传播,通过算法迭代与人工复核相结合的方式加强内容真实性验证;对于隐私泄露风险,利用加密算法与数据匿名化技术,构筑用户隐私保护屏障。

(3)为破解AIGC决策“黑箱”,可根据《建议稿》第35条规定,建立算法解释制度,确保决策过程的透明度与可理解性,降低算法歧视的可能性。第一,建立健全算法审查体系,算法构思阶段即嵌入公平正义理念,通过明确的审查准则,筛查算法设计中可能存在的偏见与歧视,实现算法逻辑的全程追踪与公正审视。第二,开发用户友好的算法审计工具,便于非技术背景的监管者乃至普通民众解读算法逻辑,评估决策合理性与潜在社会影响,构建广泛的社会监督网络,促进技术民主化进程。第三,设置反馈与复审机制,确保受影响个体或群体有权质疑算法决策,申请复核。这既能为遭受不公对待者提供申诉途径,也能促使算法设计者持续自我反思与优化,维护算法决策的公正。

5 结语

“可信治理”作为AIGC产业发展的核心诉求,其六大治理标准——可控性、可问责性、公平性、可靠性、可解释性和安全性,不仅是理论框架的基石,更是实践操作的指南。通过深入剖析《建议稿》可知,法律与政策的前瞻性布局对于指导AIGC伦理风险治理至关重要。技术伦理风险治理不能孤立于技术进步之外,针对算法歧视加剧、责任追究困境、人类主体地位削弱等风险,必须兼顾技术、法律、伦理多个维度制定解决方案。对此,完善数据风险治理架构、优化侵权风险防范与归责体系、健全伦理治理制度,是推动AIGC可信发展的必经之路。同时,面对AIGC伦理风险的全球性挑战,本土化的治理策略需在国际交流和合作中不断磨合与优化,持续审视技术发展与社会伦理的动态平衡,确保AIGC的创新潜能在尊重人权、促进公平与正义的前提下得以释放。

未来应进一步结合市场发展情况与我国国情,以可信治理为核心,以《建议稿》为出发点,构建全方位的AIGC伦理风险治理体系。另外,还需在伦理治理领域进行持续探索,关注如何将技术伦理与法律治理有机结合,以制定具有中国特色的AI伦理治理方案,顺应乃至引领全球新一轮数字经济高质量发展。

参考文献:

[1] 刘艳红.生成式人工智能的三大安全风险及法律规制——以ChatGPT为例[J].东方法学,2023,16(4): 29-43.

[2] 陈兵.生成式人工智能可信发展的法治基础[J].上海政法学院学报(法治论丛),2023,38 (4): 13-27.

[3] 陈兵,董思琰.生成式人工智能的算法风险及治理基点[J].学习与实践,2023,40(10): 22-31.

[4] 陆小华,陆赛赛.论生成式人工智能侵权的责任主体——以集体主义为视角[J].南昌大学学报(人文社会科学版),2024,55 (1): 119-131.

[5] MARCHANDOT B,MATSUSHITA K,CARMONA A,et al. ChatGPT: the next frontier in academic writing for cardiologists or a Pandora′s box of ethical dilemmas[J]. European Heart Journal Open,2023,3(2):oead007.

[6] RICH A S,GURECKIS T M. Lessons for artificial intelligence from the study of natural stupidity[J]. Nature Machine Intelligence,2019,1(4):174-180.

[7] GOODWIN M. Complicit bias and the supreme court[J].Harvard Law Review Forum,2022,52(2):107-119.

[8] 吕雪梅.美国预测警务中基于大数据的犯罪情报分析[J].情报杂志, 2015,34 (12): 16-20.

[9] 许中缘,郑煌杰. ChatGPT类应用风险的治理误区及其修正——从“重构式规制”到“阶段性治理”[J].河南社会科学,2023,31 (10): 50-62.

[10] 彭中礼.新兴技术推动法理论变革的因素考量——以人工智能产品侵权责任分配理论为例的反思[J].甘肃社会科学,2022,44(4): 115-128.

[11] 付其运.人工智能非主体性前提下侵权责任承担机制研究[J].法学杂志,2021,42 (4): 83-90.

[12] 坤海,徐来.人工智能对侵权责任构成要件的挑战及应对[J].重庆社会科学,2019,37 (2): 55-65.

[13] HYLAND T. Artificial Intelligence (AI) developments and their implications for humankind: a critical analysis of contemporary trends and perspectives[J]. Current Journal of Applied Science and Technology,2023,42(21):12-26.

[14] STOKEL-WALKER C,VAN NOORDEN R. What ChatGPT and generative AI mean for science[J]. Nature,2023,614(7947):214-216.

[15] 郭金彬,黄长平.哥德尔不完全性定理的科学推理意义[J].自然辩证法通讯,2010,32 (2): 15-20,126.

[16] 贾丽艳.海德格尔的技术哲学:祛魅与返魅的存在论反思[J].社会科学研究, 2024,46(2): 153-159.

[17] 陈志刚.马克思的工具理性批判思想——兼与韦伯思想的比较[J].科学技术与辩证法,2001,38(6): 38-41,67.

[18] 余成峰.卢曼社会系统论视野下的法律功能[J]. 北京航空航天大学学报(社会科学版),2021,34 (1): 31-41.

[19] 兰立山.技术治理的伦理风险及其应对之策[J].道德与文明,2023,42 (5): 159-167.

[20] 劳伦斯·莱斯格.代码2.0:网络空间中的法律[M].北京:清华大学出版社,2009.

[21] 张慧敏,陈凡.从自主的技术到技术的政治——L·温纳(Langdon Winner)的技术哲学思想及启示[J].自然辩证法研究,2004,20(8): 61-64.

[22] 雷·库兹韦尔.灵魂机器的时代:当计算机超过人类智能时[M].上海:上海译文出版社,2002.

[23] SHARMA A. The escalation of ChatGPT: how ChatGPT will exert influence on the legal profession[J].Jus Corpus Law Journal,2022,43(3): 95-106.

[24] 张春春, 孙瑞英.如何走出AIGC的“科林格里奇困境”:全流程动态数据合规治理[J]. 图书情报知识,2024,41 (2): 39-49,66.

[25] 袁康,鄢浩宇.数据分类分级保护的逻辑厘定与制度构建——以重要数据识别和管控为中心[J].中国科技论坛,2022,38(7): 167-177.

[26] 卢彪,姚萍.技术时代的责任风险与防范[J].江苏社会科学,2013,34(2): 109-112.

[27] 冯子轩.生成式人工智能应用的伦理立场与治理之道:以ChatGPT为例[J].华东政法大学学报,2024,27 (1): 61-71.

(责任编辑:万贤贤)